えんぴっちょ

えんぴっちょChatGPTは非常に強力なツールですが、学習データが限定されているため、社内固有のデータやリアルタイムの情報に基づいた回答は苦手です。その結果、回答の信頼性が揺らいだり、業務効率化の壁に突き当たったりすることもあるでしょう。

本記事では、こうした課題を解決する「RAG(検索拡張生成)」という技術に焦点を当てます。RAGの基本的な仕組みから、具体的な実装手順、さらには応用的なテクニックまで、エンジニアやAIリサーチャーの方々が求める情報を網羅的に解説します。

この記事を読めば、ChatGPTの潜在能力を最大限に引き出し、あなたの業務や開発プロジェクトを次のレベルへと導く具体的な方法がわかります。

ChatGPTとRAGとは?基本概念と重要性

はじめに、ChatGPTとRAGの基本的な概念と、なぜ今この組み合わせが重要視されているのかについて解説します。それぞれの技術が持つ特性を理解し、両者を組み合わせることで生まれる新たな可能性について見ていきましょう。

ChatGPTの概要

ChatGPTは、OpenAIによって開発された大規模言語モデル(LLM)です。膨大なテキストデータで事前学習されており、人間のように自然な対話ができます。文章の作成や要約、翻訳、アイデア出しなど、多様なタスクをこなせるため、多くのビジネスシーンで活用が進んでいます。

しかし、その知識は学習した時点の情報に限られるため、最新の出来事や社内のような限定的な情報には対応できないという課題も抱えています。

RAGの基本概念

RAGは「Retrieval-Augmented Generation」の略で、日本語では「検索拡張生成」と訳されます。 この技術は、ChatGPTのような生成AIに対し、外部のデータベースから関連情報を検索して参照させる仕組みです。

ユーザーから質問を受けると、まずその内容に関連する情報をデータベースから探し出し、その情報と元の質問を組み合わせてAIに渡すことで、より正確で根拠のある回答を生成させます。

RAGが注目される理由

RAGが注目される最大の理由は、ChatGPTが抱える「ハルシネーション(もっともらしい嘘をつく現象)」や「知識の鮮度の限界」といった課題を解決できる点にあります。 外部の信頼できる情報源を都度参照するため、情報の正確性が格段に向上します。

また、社内マニュアルや顧客データといった独自の情報をデータベース化すれば、業務に特化した高精度なAIアシスタントを構築できるため、多くの企業で導入が検討されています。

ChatGPTとRAGの違い

ChatGPT単体とRAGを組み合わせた場合、その最大の違いは「情報の参照元」にあります。ChatGPTは内部に保持する学習済み知識のみで回答を生成しますが、RAGを導入したシステムは、外部の特定データベースを情報源として活用します。これにより、情報の正確性や鮮度、専門性が大幅に向上します。

| 比較項目 | ChatGPT(単体) | ChatGPT + RAG |

| 知識ソース | 事前学習した内部データのみ | 内部データ + 外部データベース |

| 情報の鮮度 | 学習データ時点まで(古い) | リアルタイムに更新可能 |

| 信頼性 | ハルシネーションのリスクがある | 情報源を明示でき、信頼性が高い |

| 専門性 | 一般的な知識に限られる | 社内情報など専門分野に対応可能 |

| カスタマイズ性 | 限定的(プロンプトによる調整) | データベースの更新で容易にカスタマイズ |

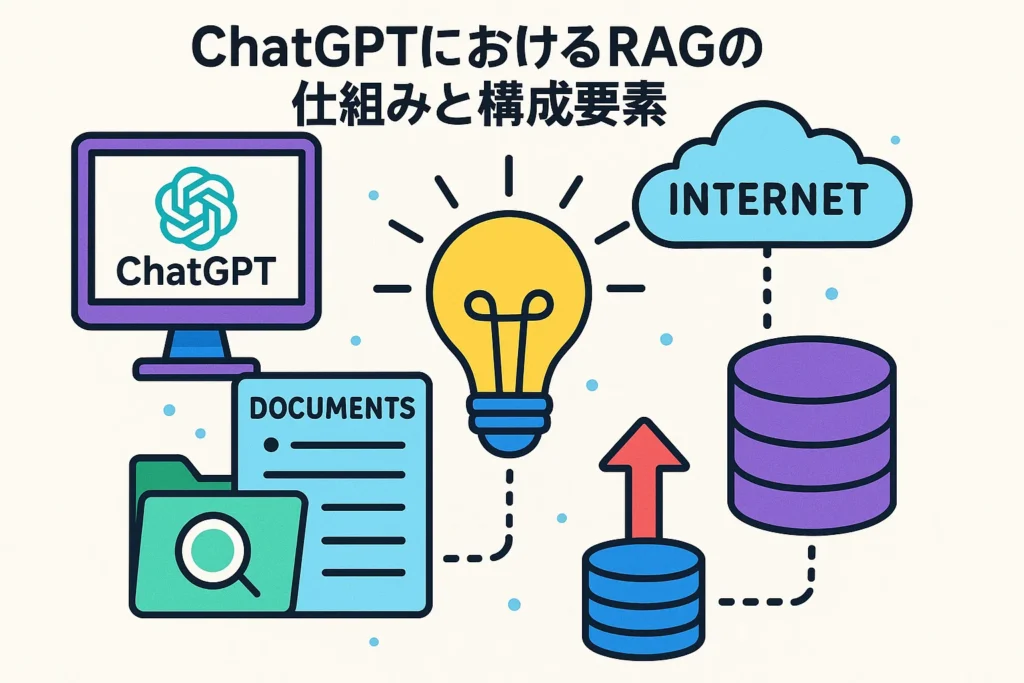

ChatGPTにおけるRAGの仕組みと構成要素

ChatGPTでRAGを実現するためには、どのような仕組みが動いているのでしょうか。ここでは、検索と生成を組み合わせたプロセスから、それを支える重要な構成要素であるベクトルデータベースの役割まで、RAGの裏側を詳しく解説します。

検索と生成を組み合わせたプロセス

RAGのプロセスは、大きく「検索(Retrieval)」と「生成(Generation)」の2段階に分かれています。 まず、ユーザーからの質問を受け取ると、システムは外部のデータベースを検索し、質問内容と関連性の高い情報を探し出します。

次に、見つけ出した情報と元の質問文を合わせてプロンプトとして整形し、ChatGPTのような生成AIに渡します。AIは、その与えられた情報に基づいて、最終的な回答を生成するのです。

情報取得・加工・回答生成の流れ

RAGシステムの具体的な処理の流れは、以下のステップで構成されています。この一連の流れにより、単にAIが記憶している情報だけでなく、外部の正確なデータに基づいた応答が可能になります。

- ユーザーが質問を入力する

- 質問内容と関連性の高い情報をデータベースから検索する

- 検索結果と元の質問を組み合わせ、AIへの指示文(プロンプト)を作成する

- 作成したプロンプトをChatGPTに送信する

- ChatGPTが情報に基づいた回答を生成し、ユーザーに提示する

リアルタイム情報を反映する仕組み

RAGが最新情報やリアルタイムのデータを扱えるのは、参照する外部データベースを常に最新の状態に保つことができるためです。 例えば、ニュース記事や株価情報、社内の最新ドキュメントなどを定期的にデータベースに登録・更新しておくことで、ChatGPTはいつでも新しい情報に基づいた回答を生成できます。

これにより、情報の鮮度が重要な金融業界や法改正が頻繁な分野でも、正確な情報提供が実現します。

ベクトルデータベースの役割

RAGの仕組みにおいて心臓部ともいえるのが「ベクトルデータベース」です。 このデータベースは、テキストデータを「ベクトル」と呼ばれる数値の配列に変換して保存します。ベクトル化することで、単語の完全一致ではなく「意味の近さ」で情報を検索できるようになります。

例えば、「会社の福利厚生」という質問に対して、「休暇制度」や「住宅手当」といった関連情報も効率的に探し出すことが可能です。この高速かつ柔軟な検索技術が、RAGシステムの精度を支えています。

ChatGPTでRAGが必要な理由とメリット

なぜ多くの開発者や企業がChatGPTにRAGを組み合わせるのでしょうか。その背景には、AIの信頼性向上やコスト削減といった、ビジネスに直結する明確なメリットが存在します。ここでは、RAGがもたらす具体的な利点と、多様な分野への応用可能性について掘り下げていきます。

信頼性向上と幻覚防止

ChatGPTの大きな課題の一つが、事実に基づかない情報を生成するハルシネーションです。RAGは、回答を生成する際に必ず外部の信頼できるデータベースを参照するため、このハルシネーションのリスクを大幅に軽減できます。

回答の根拠となる情報源を明示することも可能なため、ユーザーは情報の正しさを自ら確認でき、AIシステム全体の信頼性が向上します。 これは、正確性が求められる業務において極めて重要なメリットです。

コスト削減と業務効率化

AIに特定の専門知識を学習させる手法として「ファインチューニング」がありますが、これには大量のデータと高い計算コストが必要です。 一方、RAGは外部データベースを更新するだけで済むため、低コストかつ迅速にAIの知識をアップデートできます。

これにより、社内FAQの自動応答や顧客サポートの効率化などを手軽に実現でき、人件費の削減と業務全体の生産性向上に直接貢献します。

多様な業界・分野への応用

RAGの技術は、その汎用性の高さから、さまざまな業界での応用が期待されています。 例えば、以下のような活用が考えられます。

- 金融業界: 最新の市場動向や法規制に基づいた情報提供

- 医療分野: 最新の研究論文や治療ガイドラインの参照

- 法律分野: 膨大な判例や法令データの検索と要約

- 製造業: 複雑な製品マニュアルや仕様書の検索

このように、専門知識が求められるあらゆる分野で、業務の精度と効率を飛躍的に高めることができます。

ユーザー満足度と顧客体験の向上

顧客からの問い合わせに対して、迅速かつ正確な回答を提供することは、ユーザー満足度を向上させる上で不可欠です。RAGを組み込んだチャットボットは、24時間365日、社内のFAQや製品情報に基づいた的確なサポートを提供できます。

これにより、顧客は待ち時間なく問題を解決でき、企業はサポート業務の負担を軽減しながら、より質の高い顧客体験を創出することが可能になります。

ChatGPTとRAGの使い方と実装準備

RAGを実際に導入するには、どのような準備が必要になるのでしょうか。このセクションでは、開発環境の構築から必要なツールの選定、そしてセキュリティに関する注意点まで、実装を始める前に押さえておくべきポイントを具体的に解説します。

必要なツールと環境の準備

RAGシステムを構築するためには、まず開発環境を整える必要があります。一般的には、プログラミング言語であるPythonが広く使われています。 加えて、開発を効率化するためのライブラリやフレームワークの準備も欠かせません。

- Python実行環境: PCへの直接インストールや仮想環境の利用

- ライブラリ: LangChainやLlamaIndexなどのフレームワーク

- 開発ツール: Jupyter NotebookやVSCodeなどのエディタ

これらのツールを準備することで、スムーズに開発をスタートできます。

OpenAI APIキーとデータ準備

ChatGPTをシステムに組み込むためには、OpenAIが提供するAPIキーが必須です。 OpenAIの公式サイトからアカウントを登録し、APIキーを取得してください。 同時に、RAGの知識源となるデータを準備します。

社内マニュアル(PDF、Word)、Webサイトのコンテンツ、FAQリストなど、AIに参照させたいドキュメントを整理し、テキストデータとして利用できる状態にしておきましょう。

Pythonとベクトルデータベースの基礎

RAGの実装には、Pythonの基本的な知識が役立ちます。 特に、LangChainのようなフレームワークは、RAG構築に必要な多くの機能を部品として提供しており、開発プロセスを大幅に簡略化してくれます。

また、ベクトルデータベースの選定も重要です。ChromaやFAISSのようなオープンソースのツールは、小規模な開発から始めるのに適しています。これらのツールの基本的な使い方を理解しておくことで、実装がより円滑に進みます。

セキュリティとプライバシーへの配慮

社内情報などの機密データを扱う場合、セキュリティ対策は最も重要な課題の一つです。OpenAI APIを利用する際は、送信したデータがモデルの学習に使われない設定になっているかを確認する必要があります。

また、データベースへのアクセス管理を徹底し、権限のないユーザーが情報に触れられないようにすることも重要です。 データの暗号化や、利用状況を監視するログの取得など、多層的なセキュリティ対策を講じることを強く推奨します。

詳しくは、デジタル庁の「行政の進化と革新のための生成AIの調達・利活用に係るガイドライン」なども参考にしてください。

ChatGPTを使ったRAG実装手順とチャットボット構築ステップ

ここからは、実際にRAGを実装し、チャットボットを構築するための具体的な手順をステップバイステップで解説します。データの準備からシステムの改善まで、各工程のポイントを押さえながら、実践的な開発プロセスを見ていきましょう。

テキスト抽出とデータクレンジング

最初のステップは、知識源となるドキュメントからテキスト情報を抽出することです。PDFやWord、HTMLなど、様々な形式のファイルからテキストだけを取り出します。

抽出したテキストには、不要なヘッダーやフッター、広告などが含まれていることがあるため、「データクレンジング」という作業でこれらのノイズを除去し、整形します。この前処理の質が、後の検索精度に大きく影響します。

データベース構築とチャンク分割

次に、クレンジングしたテキストをベクトルデータベースに格納します。長いテキストはそのままでは扱いにくいため、「チャンク分割」という手法で、意味のあるまとまり(段落など)ごとに小さな単位に分割します。

このチャンクごとにベクトル化を行い、データベースに登録していきます。チャンクのサイズを適切に設定することが、検索精度を高める上で重要なポイントとなります。

情報検索・ベクトル化・類似度計算

ユーザーから質問が入力されると、その質問文も同様にベクトル化します。そして、この質問ベクトルと、データベースに保存されているチャンクのベクトルとの「類似度」を計算します。

ベクトル空間上で距離が近いものほど、意味的に関連性が高いと判断されます。類似度スコアが高い順にいくつかのチャンクを検索結果として取得し、次のステップに渡します。

ChatGPT連携による回答生成

前のステップで取得した関連性の高いチャンク(コンテキスト)と、ユーザーの元の質問文を組み合わせます。これらを特定のテンプレートにはめ込み、ChatGPTへの指示(プロンプト)を作成します。「以下の情報を参考にして、質問に答えてください」といった形式が一般的です。このプロンプトをOpenAI APIに送信し、最終的な回答を生成させます。

テスト・チューニングと改善

システムが完成したら、様々な質問を投げてテストを行い、回答の精度を評価します。期待通りの回答が得られない場合は、各ステップの設定を見直す「チューニング」が必要です。

例えば、チャンクの分割方法を変えたり、検索するチャンクの数を調整したり、プロンプトの指示内容を工夫したりすることで、精度を改善していきます。この試行錯誤のプロセスが、システムの質を高める鍵となります。

プロンプト設計と評価のポイント

RAGの性能を最大限に引き出すには、プロンプトの設計が非常に重要です。 AIに対して役割(例:「あなたは〇〇の専門家です」)を与えたり、回答の形式を指定したり、参照した情報源を明記させたりするなど、明確な指示を与えることで回答の質が向上します。

評価の際には、「Faithfulness(忠実性)」や「Answer Relevancy(回答の関連性)」といった指標を用いて、生成された回答が提供された情報に忠実か、そして質問に適切に答えているかを客観的に判断します。

ChatGPTで活用するRAG拡張手法と効果的なテクニック

基本的なRAGの実装に慣れたら、次はその精度や性能をさらに向上させるための高度なテクニックに挑戦してみましょう。ここでは、より複雑な質問に対応したり、検索の質を高めたりするための応用的な拡張手法をいくつか紹介します。

ハイブリッドサーチとリランキング

ハイブリッドサーチは、意味の近さで検索する「ベクトル検索」と、キーワードの一致で検索する従来の「キーワード検索」を組み合わせる手法です。これにより、専門用語や固有名詞を含む質問に対して、より網羅的で精度の高い検索結果を得ることができます。

さらに「リランキング」という技術を使い、一度検索した結果を、より高度なモデルで再度評価し、関連性の高い順に並べ替えることで、回答の質を一層高めることが可能です。

サブクエリとマルチステップ戦略

「AとBの違いをCの観点から教えてください」のような複雑な質問は、一度の検索では適切な情報を見つけにくい場合があります。そこで「サブクエリ」という手法を使い、元の質問を「Aについて」「Bについて」といった複数の単純な質問に分解します。

それぞれのサブクエリで検索を行い、得られた情報を統合して最終的な回答を生成する「マルチステップ戦略」を取ることで、複雑な問いにも的確に答えられるようになります。

ステップバックプロンプトとRAG Fusion

「ステップバックプロンプト」は、具体的な質問から一歩引いて、より一般的で抽象的な質問をAIに生成させるテクニックです。この抽象的な質問で検索を行うことで、より広範で本質的なコンテキストを得ることができます。

一方「RAG Fusion」は、元の質問と、それを少し言い換えた複数の質問で同時に検索を行い、それらの結果を融合させてランキング付けする手法です。これにより、検索結果の偏りをなくし、頑健性を高めます。

チャンク拡張とデータベースクエリ

検索でヒットしたチャンクだけでは文脈が不足し、AIが正確な回答を生成できないことがあります。これを防ぐために、ヒットしたチャンクの前後の文章も一緒に取得する「チャンク拡張」という手法が有効です。

また、データベースに情報を格納する際に、作成日やカテゴリといった「メタデータ」を付与しておくことも重要です。これにより、「最新の〇〇に関する情報」といったメタデータに基づいた高度なデータベースクエリが可能になります。

長文コンテキストへの対応策

非常に長いドキュメント全体を要約したり、複数の文書にまたがる情報を統合したりする場合、AIが一度に処理できるコンテキストの長さを超えてしまう問題があります。この課題に対応するため、まず各ドキュメントを個別に要約し、その要約文をさらに統合して最終的な答えを生成する、といった階層的なアプローチが有効です。

これにより、膨大な情報量の中からでも、的確な回答を導き出すことが可能になります。

ChatGPTとRAG導入時の課題と対策

RAGは非常に強力な技術ですが、導入にあたってはいくつかの課題が存在します。ここでは、データ準備からコスト、セキュリティといった現実的な問題点と、それらを乗り越えるための具体的な対策について解説します。計画的に課題をクリアすることで、スムーズな導入が可能になります。

データ準備と品質管理の課題

RAGの回答精度は、参照するデータの品質に大きく依存します。これを「Garbage In, Garbage Out(ゴミを入れればゴミしか出てこない)」の原則と言います。

社内ドキュメントは形式が統一されていなかったり、古い情報や誤った情報が含まれていたりすることが少なくありません。そのため、導入前にはテキストを抽出して不要な情報を削除する「データクレンジング」や、形式を整える作業が不可欠です。この地道な品質管理が、最終的なシステムの性能を左右する重要な鍵となります。

システム導入コストとリソース

RAGシステムの導入には、初期開発コストと継続的な運用コストが発生します。 主なコスト要素は以下の通りです。

- 開発コスト: エンジニアの人件費や開発環境の構築費用

- API利用料: ChatGPTなどのLLM APIの呼び出し料金

- データベース費用: ベクトルデータベースの利用料や維持管理費

特にAPI利用料は、システムの利用頻度に応じて変動するため注意が必要です。 導入前に、どの程度の利用が見込まれるかを試算し、予算計画を立てることが重要です。

セキュリティリスクと対策

社内の機密情報や個人情報を含むデータを扱う場合、セキュリティ対策は最優先事項です。 クラウドサービスを利用する際は、データがどのように扱われるか、サービス提供者のセキュリティポリシーを十分に確認する必要があります。 具体的な対策としては、以下のようなものが挙げられます。

- アクセス制御の徹底

- データの暗号化

- APIキーの厳重な管理

- 定期的な脆弱性診断

これらの対策を講じることで、情報漏洩のリスクを最小限に抑えることができます。公的機関が発行するガイドライン、例えば情報処理推進機構(IPA)のセキュリティ情報なども参考にすることをお勧めします。

スモールスタートと運用改善

最初から全社規模の壮大なシステムを目指すのではなく、特定の部署や用途に限定して小さく始める「スモールスタート」が成功の秘訣です。

例えば、まずは情報システム部門のFAQ対応ボットから始めることで、導入のノウハウを蓄積し、課題を洗い出すことができます。 実際に運用しながらユーザーからのフィードバックを集め、データの追加やチューニングを繰り返していくことで、システムを段階的に成長させていくアプローチが効果的です。

専門サービスと自社開発の選択肢

RAGシステムを導入するには、自社で一から開発する方法と、外部の専門サービスを利用する方法があります。それぞれにメリットとデメリットがあるため、自社の技術力や予算、目的に合わせて最適な選択をすることが重要です。

| 自社開発 | 専門サービスの利用 | |

| メリット | ・柔軟なカスタマイズが可能 ・独自のセキュリティ要件に対応しやすい ・長期的なコストを抑えられる可能性がある | ・専門知識がなくても導入可能 ・開発期間を大幅に短縮できる ・運用や保守を任せられる |

| デメリット | ・高度な技術力と開発リソースが必要 ・開発に時間がかかる ・維持管理の負担が大きい | ・カスタマイズの自由度が低い場合がある ・サービス利用料が継続的に発生する ・外部サービスへの依存 |

| 向いているケース | ・社内にAI開発の専門チームがある ・独自の複雑な要件がある ・長期的な視点で内製化を進めたい | ・迅速に導入したい ・社内に開発リソースがない ・まずは効果を検証したい |

ChatGPT RAG活用の応用例とユースケース

RAGの技術は、具体的にどのような場面で活用できるのでしょうか。ここでは、社内の業務効率化から顧客対応の質の向上まで、さまざまな分野におけるRAGの応用例と具体的なユースケースを紹介します。自社の課題解決のヒントを見つけてみてください。

社内FAQボットの構築例

多くの企業では、人事、経理、情報システムといった部署に同じような質問が繰り返し寄せられます。 社内規定や各種申請手続きのマニュアルをRAGのデータベースに読み込ませることで、これらの問い合わせに24時間自動で回答するFAQボットを構築できます。

これにより、担当部署の負担を大幅に軽減できるだけでなく、従業員はいつでも必要な情報をすぐに入手できるようになり、全体の生産性が向上します。

製品マニュアル検索システム

特に複雑な製品やソフトウェアを扱う企業にとって、顧客からの技術的な問い合わせ対応は大きな負担です。分厚い製品マニュアルや技術仕様書をRAGで検索できるようにすれば、サポート担当者は顧客の質問に対して迅速かつ正確に回答箇所を見つけ出すことができます。

さらに、このシステムを顧客自身が使えるようにWebサイトで公開すれば、自己解決を促し、問い合わせ件数そのものを削減する効果も期待できます。

個人用ナレッジベースと教育活用

RAGは組織だけでなく、個人の知識管理ツールとしても非常に強力です。自分が読んだ論文や書籍のメモ、参加した会議の議事録などをデータベース化すれば、必要な情報をいつでも対話形式で引き出せる「第二の脳」のような使い方ができます。

教育分野では、学生が大量の教科書や参考資料を読み込み、特定のテーマについてAIと対話しながら学習を深めるといった活用法も考えられます。

業界別の導入事例

RAGの活用範囲は業界を問いません。それぞれの業界特有の課題解決に貢献しています。

- 金融業界: 膨大な金融商品や法規制に関する情報から、顧客のニーズに合った提案を生成する。

- 医療業界: 最新の医学論文や臨床試験データを検索し、医師の診断や研究を支援する。

- 法律業界: 過去の判例や法令をデータベース化し、弁護士のリーガルリサーチを効率化する。

- 製造業界: 過去の設計図やトラブル事例を検索し、製品開発や保守業務の質を向上させる。

マーケティングと顧客対応の活用例

マーケティング分野では、顧客の購買履歴やWebサイト上の行動ログをRAGのデータベースに活用できます。これにより、顧客一人ひとりの興味関心に合わせたパーソナライズされた商品説明やレコメンドを自動生成することが可能です。

また、コールセンターでは、過去の応対履歴をRAGで検索できるようにすることで、新人オペレーターでもベテラン並みの質の高い顧客対応が可能になり、顧客満足度の向上に繋がります。

ChatGPTとRAGの将来性と可能性

RAGは現在進行形で進化を続けている技術です。今後、AI技術の発展とともに、RAGはどのような可能性を秘めているのでしょうか。ここでは、AIの進化がRAGに与える影響や、将来期待される新しい活用法について展望します。

長いコンテキストとRAGの必要性

近年、ChatGPTのようなLLMが一度に処理できるテキスト量(コンテキストウィンドウ)は飛躍的に増大しています。しかし、どれだけコンテキストが長くなっても、すべての社内ドキュメントを一度に読み込ませるのは現実的ではありません。

また、情報の最新性を担保するという観点からも、必要な情報をその都度外部から検索してくるRAGの役割は、今後も重要であり続けるでしょう。長いコンテキストを扱える能力と、RAGの検索能力は、互いに補完し合う関係になると考えられます。

AI技術との融合と拡張

現在のRAGは主にテキストデータを扱いますが、将来的には画像、音声、動画といった様々な形式のデータを統合的に扱う「マルチモーダルRAG」が主流になると予測されています。

例えば、製品の画像を見せて「この部品の交換方法を教えて」と質問すると、システムがマニュアル動画の中から該当シーンを検索して提示するといった、より人間に近い直感的なやり取りが実現するでしょう。 この技術は、AIの活用範囲をさらに大きく広げる可能性を秘めています。

今後の研究動向と課題

RAGの性能をさらに向上させるための研究が世界中で活発に行われています。より賢い検索方法の開発(自己修正検索)、複数のデータベースを横断的に検索する技術、あるいは検索結果の信頼性をAI自身が評価する仕組みなど、様々なアプローチが探求されています。

今後の課題としては、これらの高度な機能を、より少ない計算コストで、誰もが簡単に利用できるようにしていくことが挙げられます。技術の進化とともに、RAGはさらに強力で使いやすいツールへと発展していくでしょう。

大規模モデルの進化とRAGの役割

LLM自体の性能が向上し、より多くの知識を内部に保持できるようになっても、RAGの重要性が失われることはありません。なぜなら、企業が持つ固有のデータや、日々更新される最新の情報は、汎用的な大規模モデルには含まれていないからです。

モデルの「一般的な賢さ」と、RAGが提供する「専門的で正確な情報」を組み合わせることで、初めてビジネスの現場で真に役立つAIシステムが実現します。モデルの進化は、RAGの価値をさらに高めることに繋がるのです。

ChatGPTとRAGに関するよくある質問

ここでは、ChatGPTとRAGに関して多くの方が抱く疑問について、Q&A形式で分かりやすくお答えします。導入を検討する上での不明点を解消し、理解をさらに深めていきましょう。

ChatGPTとRAGを組み合わせるメリットは何ですか?

最大のメリットは、ChatGPTの回答の信頼性を大幅に向上させられる点です。事実に基づかない情報を生成する「ハルシネーション」を抑制できます。 また、社内文書など独自のデータを参照させることで、業務に特化した回答が可能になります。

さらに、モデル全体を再学習させるファインチューニングに比べて、低コストかつ迅速に最新情報を反映できる点も大きな利点です。

RAGを導入する際の費用はどれくらいですか?

費用はシステムの規模や構成によって大きく異なります。自社で開発する場合、主にエンジニアの人件費が初期コストとしてかかります。

運用コストとしては、ChatGPTのAPI利用料やベクトルデータベースのサービス利用料などが月額で発生します。 スモールスタートであれば月数万円程度から始めることも可能ですが、全社規模での利用や大量のデータを扱う場合は、より高額になる可能性があります。

RAGとファインチューニングの違いは?

RAGとファインチューニングは、どちらもAIを特定のタスクに特化させる手法ですが、そのアプローチが根本的に異なります。RAGがAIの「外部脳」としてデータベースを参照するのに対し、ファインチューニングはAI自体に追加学習を施し「内部の知識や振る舞い」を変化させるイメージです。

| 比較項目 | RAG(検索拡張生成) | ファインチューニング |

| アプローチ | 外部データベースを検索・参照して回答 | モデル自体を特定のデータで再学習 |

| 目的 | 知識の追加、最新情報の反映、ハルシネーション抑制 | モデルの応答スタイルや特定の専門分野への特化 |

| コスト | 初期コストは比較的低いが、運用コストが発生 | 高い計算コストと専門知識が必要 |

| 更新性 | データベースを更新するだけで良いため、容易かつ迅速 | データが更新されるたびに再学習が必要 |

| 得意なこと | 事実に基づく正確な回答、情報源の明示 | 特定の文体や対話スタイルの模倣、専門用語への適応 |

RAG導入時のセキュリティ対策は?

機密情報を扱う場合、厳重なセキュリティ対策が不可欠です。 具体的には、誰がどのデータにアクセスできるかを制御する「アクセス権管理」、通信や保存データを保護する「暗号化」、不正なアクセスを防ぐための「ネットワーク分離」などが挙げられます。

利用するクラウドサービスが、業界標準のセキュリティ認証を取得しているかを確認することも重要です。

社内データの準備に必要なステップは?

まず、RAGの知識源としたい社内ドキュメント(マニュアル、規定集、議事録など)を収集します。 次に、PDFやWordなどのファイルからテキストデータを抽出します。

抽出したデータには不要な情報が含まれていることが多いため、それらを削除・整形する「クレンジング」作業を行います。 最後に、整形したデータを意味のある塊(チャンク)に分割し、ベクトルデータベースに登録するという流れが一般的です。

ChatGPTとRAGのまとめ

本記事では、ChatGPTの能力を飛躍的に向上させる技術「RAG」について、その基本的な仕組みから具体的な実装手順、さらには応用的なテクニックや将来性に至るまで、幅広く解説しました。

RAGは、ChatGPTが抱えるハルシネーションや情報の鮮度の問題を解決し、回答の信頼性を格段に高めるための鍵となります。社内ドキュメントや専門知識を組み合わせることで、自社の業務に特化した高精度なAIアシスタントを、比較的低コストで構築することが可能です。

社内FAQの自動化による業務効率化や、顧客対応の品質向上など、その活用範囲は多岐にわたります。もちろん、データ品質の管理やセキュリティ対策といった課題も存在しますが、スモールスタートで始め、運用しながら改善を重ねていくことで、その効果を最大限に引き出すことができるでしょう。この記事が、あなたの会社でAI活用の新たな一歩を踏み出すきっかけとなれば幸いです。