えんぴっちょ

えんぴっちょAIモデルの開発で「推論速度が遅い」と悩んでいませんか。時間をかけて開発したモデルも、処理速度が遅ければ実用化は難しく、ユーザー体験を損なう原因にもなりかねません。このままでは、あなたの貴重な開発時間が無駄になってしまうかもしれません。この記事では、そうした悩みを解決するNVIDIAの強力なツール「TensorRT」について、基礎的な知識から具体的な導入方法、そして実践で役立つ活用事例までを分かりやすく解説します。この記事を最後まで読めば、TensorRTを使いこなし、AIモデルの推論を劇的に高速化させる方法がわかります。あなたのAI開発を次のステージへ進めるために、ぜひご一読ください。

【この記事でわかること】

TensorRTとは?基礎知識とメリットを解説

TensorRTは、AI開発における推論処理を高速化するための強力なツールです。AIモデルは学習済みであっても、実際にデータを使って予測や分類を行う「推論」の段階で時間がかかることがあります。この課題を解決するために、NVIDIAが提供しているのがTensorRTです。ここでは、TensorRTが持つ特徴と、開発者にもたらすメリットについて、基礎からわかりやすく解説していきます。

NVIDIA TensorRTの特徴とメリット

NVIDIA TensorRTの最大の魅力は、なんといってもAIモデルの推論処理を大幅に速くできる点です。学習済みのAIモデルをTensorRTで最適化することにより、NVIDIA GPUの性能を最大限に引き出します。これにより、リアルタイムでの画像認識や自然言語処理など、高速な応答が求められるアプリケーションの実現が可能になります。

また、推論の効率が上がることで、同じ時間でより多くのデータを処理できるようになり、サーバーコストの削減にもつながるでしょう。開発者にとっては、複雑な最適化を手動で行う手間が省け、より本質的な開発作業に集中できるという大きなメリットがあります。

| 項目 | 内容 |

| 主な特徴 | AI推論の高速化に特化したSDK |

| メリット | ・推論速度の向上 ・スループットの最大化 ・開発効率の向上 ・サーバーコストの削減 |

| 開発元 | NVIDIA |

| 対応フレームワーク | TensorFlow, PyTorch, ONNXなど |

TensorRTエコシステムを構成する4つの要素

TensorRTは、いくつかの要素が連携して動く「エコシステム」として成り立っています。この仕組みを理解することで、TensorRTをより効果的に活用できます。主に4つの要素で構成されており、それぞれが大切な役割を担っています。一つ目は、学習済みモデルを読み込む「パーサー」。二つ目は、モデルを最適化する計画を立てる「ビルダー」。三つ目は、最適化されたモデルを実行する「ランタイム」。そして最後に、これら全体を支える「プラグイン」です。これらが連携し、あなたのAIモデルを自動的に最も効率的な形へと変換してくれるのです。

TensorRTとNVIDIA GPUの関連性

TensorRTを理解する上で、NVIDIA GPUとの関係性を知ることは非常に重要です。TensorRTはNVIDIA製のGPUの上で動作することを前提に作られており、両者は切っても切れない関係にあります。GPUがAI計算を行うための「エンジン」だとすれば、TensorRTはそのエンジンの性能を極限まで引き出すための「チューニングパーツ」のような存在です。ここでは、両者の違いや、TensorRTがどのようにしてGPUを最適化するのかを具体的に見ていきましょう。

NVIDIA GPUとの違いを解説

NVIDIA GPUとTensorRTの役割は明確に異なります。NVIDIA GPUは、膨大な数の計算を同時に行うことができる「ハードウェア」です。AIの学習や推論に必要な計算処理そのものを担当します。

一方、TensorRTは、そのGPU上でAIモデルを最も効率良く動かすための「ソフトウェア」です。TensorRTは、AIモデルの構造を解析し、無駄な計算を省いたり、処理の順番を入れ替えたりすることで、GPUが最も得意な形で計算を行えるように手助けします。つまり、GPUが「能力」そのものであり、TensorRTは「能力の引き出し方」を最適化するツールと言えるでしょう。

| NVIDIA GPU | TensorRT | |

| 役割 | 計算処理を行うハードウェア | 処理を最適化するソフトウェア |

| 対象 | あらゆる並列計算 | AIモデルの推論処理 |

| 目的 | 高速な計算の実行 | GPU性能の最大化と推論の高速化 |

TensorRTでGPUを最適化する具体例

では、TensorRTは具体的にどのようにしてGPUの性能を引き出すのでしょうか。例えば、あるAIモデルに「畳み込み」「活性化関数」「プーリング」という3つの連続した処理があったとします。通常は、GPUがこれらを一つずつ順番に処理していきます。

しかし、TensorRTはこれらの処理を一つにまとめてしまい、「融合レイヤー」という新しい一つの処理として扱います。これにより、GPUは一度の命令で3つの処理をこなせるようになり、処理と処理の間に発生するデータのやり取りが不要になります。結果として、GPUへの負荷が減り、全体の処理速度が劇的に向上するのです。これがTensorRTによる最適化の一例です。

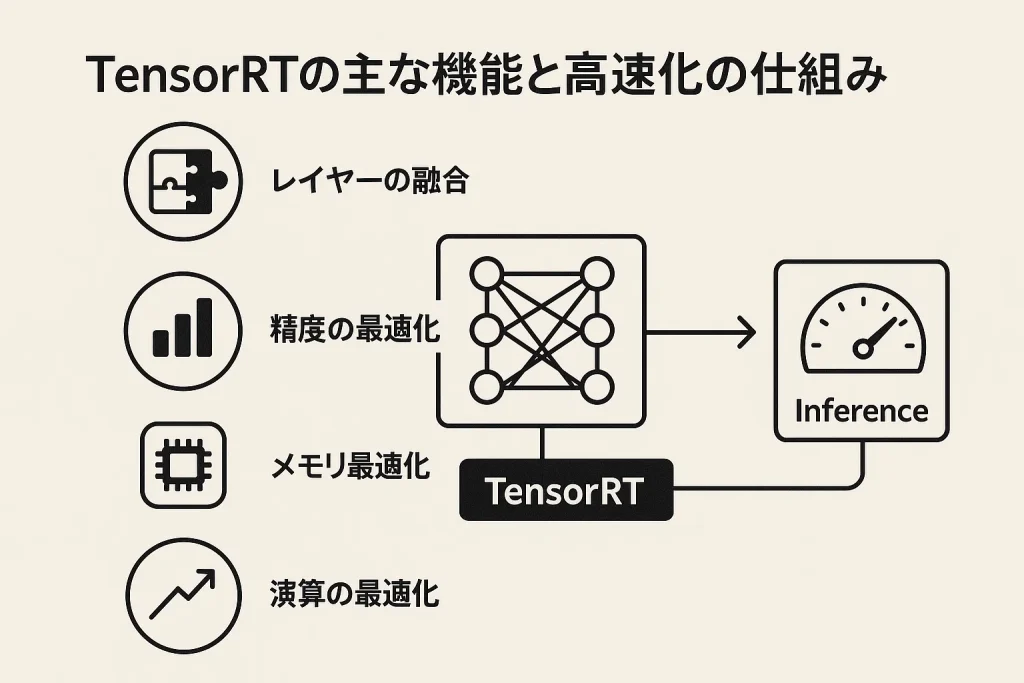

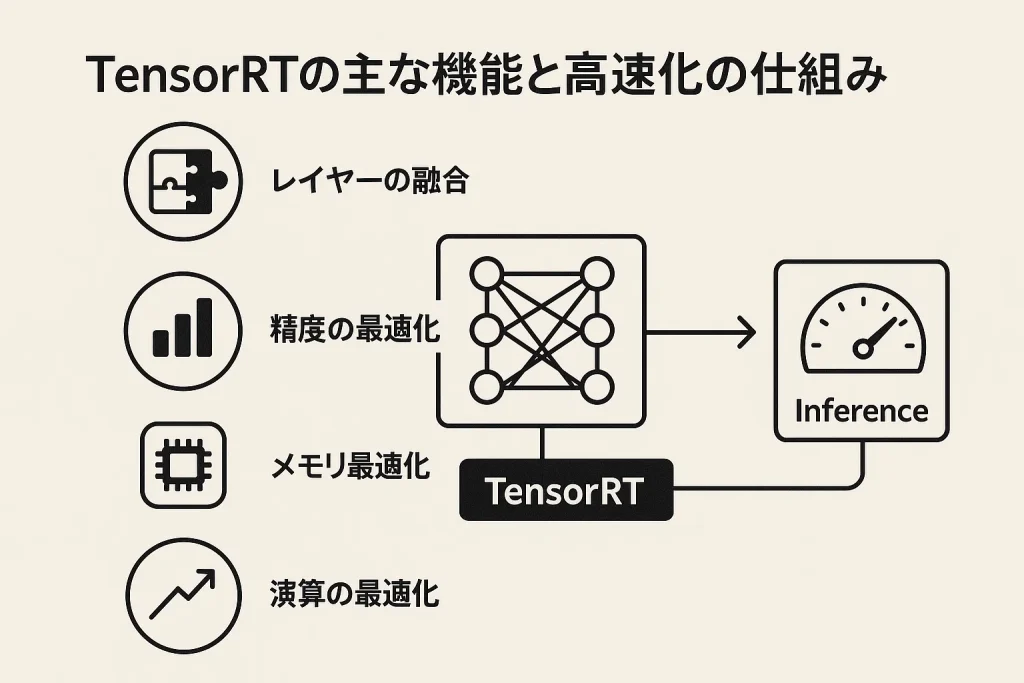

TensorRTの主な機能と高速化の仕組み

TensorRTがAIモデルの推論を驚くほど速くできるのには、いくつかの巧妙な仕組みがあります。これらの機能は、GPUの能力を最大限に活用するために設計されており、それぞれが連携して高速化を実現します。ここでは、TensorRTが持つ主な機能と、それらがどのようにして高速化に貢献しているのか、その秘密を一つずつ解き明かしていきます。この仕組みを理解すれば、あなたのAI開発にTensorRTを役立てるヒントが見つかるはずです。

レイヤーとテンソル融合で処理効率アップ

TensorRTの高速化技術の一つに「レイヤーとテンソル融合」があります。AIモデルは、多くの小さな処理の層(レイヤー)が連なってできています。TensorRTは、連続する複数のレイヤーを一つに「融合」してしまいます。これは、料理で例えるなら、野菜を「切る」「炒める」「味付けする」という工程を、一つのフライパンで同時にこなすようなものです。処理を一つにまとめることで、工程間のデータの移動時間をなくし、GPUへの命令回数を減らします。この小さな工夫の積み重ねが、最終的に大きな時間短縮につながり、処理効率を飛躍的に向上させるのです。

精度調整(FP16・INT8)による高速処理の実現

計算の「精度」を少しだけ調整することも、TensorRTが高速化を実現するための重要な手法です。AIの計算では通常、FP32という高い精度の数値を使いますが、推論の段階では必ずしもそこまでの精度は必要ない場合があります。そこでTensorRTは、よりデータ量の少ないFP16やINT8といった低い精度の数値に変換します。これは、細かいミリ単位の設計図を、センチ単位で大まかに描き直すようなものです。データ量が小さくなることで、一度に扱える情報量が増え、メモリの使用量も削減できます。結果として、GPUはより速く計算を終えることができ、推論処理全体のスピードアップが実現します。

カーネル自動チューニングでGPU性能を最大化

GPUには様々な種類があり、それぞれに得意な処理のやり方があります。TensorRTの「カーネル自動チューニング」機能は、使用しているGPUのモデルに最も適した実行方法(カーネル)を自動で選び出してくれます。これは、まるであなたのGPU専門の優秀なトレーナーがついているようなものです。TensorRTは、AIモデルとGPUの特性を分析し、数多くの選択肢の中から最も速く処理できるプログラムを適用します。この自動最適化により、開発者はGPUごとの複雑なチューニングに頭を悩ませることなく、常に最高のパフォーマンスを引き出すことができるのです。

動的メモリ管理で効率的にメモリを活用

AIモデルの計算には、大量のメモリが必要になります。TensorRTは「動的メモリ管理」という機能で、このメモリを非常に効率的に使います。これは、作業机の上を常に整理整頓するのに似ています。計算に必要なメモリを、必要なタイミングで必要な分だけ確保し、不要になったらすぐに解放します。これにより、メモリの無駄遣いを防ぎ、より大きなAIモデルや、複数のモデルを同時に動かす場合でも、メモリ不足に陥るリスクを減らします。メモリを効率的に使うことは、特にメモリ容量が限られているデバイスで推論を行う際に、大きな力を発揮します。

マルチストリーム実行による並列処理の強化

TensorRTは「マルチストリーム実行」によって、複数の処理を同時に進める並列処理を強化します。これは、複数のシェフが同時に別々の料理を作る厨房を想像すると分かりやすいでしょう。例えば、画像認識の処理を複数同時に受け付けた場合、TensorRTはそれぞれの処理を独立した流れ(ストリーム)としてGPUに割り当てます。GPUは、リソースが空いている部分をうまく使いながら、これらのストリームを並行して処理します。これにより、一つ一つの処理を待たせることなく、システム全体としての処理能力(スループット)が大幅に向上するのです。

TensorRTに対応しているGPU一覧

TensorRTは、NVIDIAが提供する幅広いGPUで利用することができます。 基本的には、比較的新しい世代のNVIDIA GPUであれば対応していると考えてよいでしょう。具体的には、データセンター向けのTeslaシリーズ、プロフェッショナル向けのQuadroシリーズ、そしてゲーミングや個人開発で広く使われているGeForceシリーズなどが含まれます。特に、AI計算に特化したTensorコアを搭載しているTuring世代以降のGPU(RTX 20シリーズ以降など)では、TensorRTの性能を最大限に活かすことが可能です。 お使いのGPUが対応しているかどうかの詳細は、NVIDIAの公式サイトで確認することをおすすめします。

| シリーズ | 主なモデル例 | 特徴 |

|---|---|---|

| NVIDIA GeForce | RTX 40/30/20 シリーズ | ゲーミング、個人開発者向け |

| NVIDIA RTX (旧Quadro) | NVIDIA RTX 6000 Ada世代など | プロフェッショナル、ワークステーション向け |

| NVIDIA データセンター GPU | H100, A100, V100, T4など | 大規模AI、HPC向け |

| NVIDIA Jetson | Jetson Orin, Jetson Xavier | エッジコンピューティング、組込み向け |

TensorRTの導入手順を詳しく解説

TensorRTの強力な機能を活用するためには、まずあなたの開発環境へ正しく導入することが第一歩です。ここからは、具体的なインストール手順をいくつかの方法に分けて詳しく解説していきます。環境構築は時に複雑に感じられるかもしれませんが、一つ一つのステップを確実に実行すれば、決して難しいものではありません。あなたに最適な方法を選んで、推論高速化の世界へ足を踏み入れましょう。

TensorRTの利用に必要な環境とは?

TensorRTを導入する前に、いくつかの前提条件を満たす必要があります。これらはTensorRTが正しく動作するための土台となるものです。主に、NVIDIA製の対応GPU、そしてそのGPUを動かすための各種ソフトウェアが必要となります。環境が整っていないと、インストール自体が失敗したり、後々予期せぬエラーの原因になったりするため、事前にしっかりと確認しておきましょう。

| 項目 | 内容 |

| 対応OS | Linux / Windows |

| GPU | NVIDIA製GPU(Pascalアーキテクチャ以降を推奨) |

| 必須ソフトウェア | ・NVIDIA GPUドライバ ・CUDA Toolkit ・cuDNN |

| 推奨環境 | Docker(環境構築の簡略化のため) |

Dockerを利用したインストール方法(推奨)

TensorRTの導入で最も簡単かつ確実な方法は、Dockerを利用することです。NVIDIAが公式に提供しているDockerイメージには、TensorRTはもちろん、CUDAやcuDNNといった必要なライブラリがすべて含まれています。 これにより、バージョン間の依存関係といった複雑な問題を気にする必要がなくなり、クリーンな実行環境をすぐに手に入れることができます。Dockerが初めての方でも、コマンド一つで環境が整うため、開発者はモデルの最適化という本来の作業に集中できるのです。まずはDocker HubからNVIDIAの公式コンテナをダウンロードすることから始めましょう。

CondaまたはPipを使ったインストール手順

Python開発者にとって馴染み深いCondaやPipを使ってTensorRTをインストールすることも可能です。この方法は、既存のPython環境に手軽に追加したい場合に便利です。例えば、Pipを使う場合は `pip install nvidia-tensorrt` のようなコマンドでインストールできます。ただし、この方法では事前に対応するバージョンのCUDA ToolkitとcuDNNがシステムにインストールされている必要があります。 また、パッケージ管理ツールで提供されるバージョンは最新でない場合があるため、利用したい機能がサポートされているかを事前に確認することが大切です。

CUDA環境へ直接インストールする方法

より細かな制御をしたい上級者向けに、CUDA環境へ直接TensorRTをインストールする方法もあります。この場合、NVIDIAの公式サイトから対応するOSとCUDAバージョンのTensorRTパッケージ(tarファイルやzipファイルなど)をダウンロードします。 その後、ダウンロードしたファイルを展開し、ライブラリファイルへのパスを通すなどの設定を手動で行う必要があります。この方法は手間がかかる一方で、特定のバージョンをピンポイントで利用したい場合や、Dockerを使えない環境で有効な選択肢となります。

インストールが成功したかの確認方法

インストール作業が完了したら、TensorRTが正しく導入されたかを確認しましょう。最も簡単な確認方法は、Python環境でTensorRTライブラリをインポートしてみることです。ターミナルやコマンドプロンプトを開き、Pythonを起動した後に `import tensorrt as trt` と入力します。エラーメッセージが表示されずにプロンプトが戻ってくれば、ライブラリは正しく認識されています。さらに、`print(trt.__version__)` を実行してバージョン番号が表示されれば、インストールは成功です。

TensorRTを使った実践的な活用事例

TensorRTは、理論上の高速化だけでなく、すでに様々なAI分野の第一線で活躍し、具体的な成果を上げています。画像認識から自然言語処理まで、その応用範囲は広く、多くのアプリケーションの性能を飛躍的に向上させてきました。ここでは、TensorRTが実際にどのように使われているのか、代表的な4つの分野における実践的な活用事例を紹介します。これらの事例は、あなたのプロジェクトにTensorRTを導入する際のヒントになるでしょう。

画像分類での推論高速化の導入事例

画像分類はAIの基本的なタスクの一つですが、大量の画像をリアルタイムで処理するには高い性能が求められます。例えば、工場の生産ラインで製品の不良品を自動で検品するシステムを考えましょう。TensorRTを導入することで、ResNetやEfficientNetといった画像分類モデルの推論を高速化し、ベルトコンベアの速度を落とすことなく、瞬時に製品の良否を判定できます。これにより、生産性の向上と品質管理の徹底を両立させることが可能になるのです。

物体検出へのTensorRT導入事例を解説

自動運転車や監視カメラなど、リアルタイムでの物体検出は多くの場面で不可欠な技術です。YOLOやSSDといった人気の物体検出モデルは、そのままでも高い精度を誇りますが、推論に時間がかかるという課題がありました。ここでTensorRTを活用することで、モデルを最適化し、処理速度を数倍に高めることが可能です。その結果、車両や歩行者を瞬時に検出し、衝突回避システムをより安全に動作させたり、不審者の侵入を即座に通知したりといった、応答速度が重要となるアプリケーションが実現します。

セグメンテーション分野のTensorRT活用方法

セグメンテーションは、画像のピクセル一つ一つをクラス分けする高度なタスクで、医療画像の解析や衛星画像の分析などに利用されます。例えば、MRI画像から腫瘍の領域を正確に特定するような場面です。U-Netなどのセグメンテーションモデルは計算コストが非常に高いですが、TensorRTで最適化することで、医師が診断を下すための時間を大幅に短縮できます。これにより、より多くの患者を診察することが可能になり、医療の質の向上に貢献します。

自然言語処理でのTensorRT最適化事例

近年、BERTやGPTといった大規模言語モデル(LLM)の活用が急速に進んでいます。これらのモデルは、チャットボットや文章の自動要約など様々なサービスで使われていますが、非常に大きな計算能力を必要とします。TensorRT、特にLLMに特化したTensorRT-LLMを用いることで、これらの巨大なモデルの推論を最適化し、ユーザーからの問い合わせに対して、まるで人間と対話しているかのような自然な速さでの応答が可能になります。これにより、ユーザー体験が大幅に向上し、サービスの満足度を高めることにつながります。

TensorRTの将来性とAI分野への影響

TensorRTは、現在のAI開発を支えるだけでなく、未来の技術革新を牽引する可能性を秘めています。推論処理の高速化は、単なる時間短縮以上の価値を持ち、これまで不可能だった新しいAIアプリケーションの創出を後押しします。ここでは、TensorRTがこれから先のAI技術の進化に、どのような影響を与えていくのか、その将来性について考えてみましょう。

TensorRTがAI技術進化にもたらす可能性

TensorRTによる推論の高速化と効率化は、AI技術の進化に多大な影響を与えます。まず、エッジデバイスでのAI活用がさらに加速するでしょう。スマートフォンやドローンといったリソースが限られた環境でも、より複雑で高性能なAIモデルを動作させることが可能になります。また、AIモデルの巨大化が進む中で、TensorRTは大規模モデルを現実的なコストと時間で運用するための鍵となります。これにより、さらに精度の高い言語モデルや画像生成モデルが生まれ、私たちの生活やビジネスをより豊かに変えていくことが期待されます。

TensorRTに関するよくある質問

TensorRTに関心を持つ開発者から、よく寄せられる質問がいくつかあります。導入の難易度や、他のツールとの違い、そしてコスト面など、実際に利用を検討する上で気になるポイントは多いでしょう。ここでは、そうした疑問に一つずつお答えしていきます。このセクションを読めば、TensorRTに対するあなたの疑問が解消され、より具体的な導入イメージが描けるはずです。

TensorRTは初心者でも簡単に導入可能か?

TensorRTの導入は、以前に比べて格段に容易になっています。特に、NVIDIAが提供する公式のDockerコンテナを利用すれば、環境構築の手間が大幅に省けるため、初心者の方でも比較的スムーズに始めることが可能です。ただし、モデルの最適化プロセスや、FP16・INT8といった精度の概念など、基本的な知識を理解しておくと、より効果的にTensorRTを使いこなせます。最初はサンプルコードを動かすところから始め、徐々に理解を深めていくのが良いでしょう。

TensorRTと他の推論エンジンとの違いは?

AIの推論エンジンはTensorRT以外にもいくつか存在します。それぞれに特徴があり、プロジェクトの要件によって最適なものは異なります。TensorRTの最大の強みは、NVIDIA GPUに特化していることで、最高のパフォーマンスを引き出せる点です。一方で、ONNX Runtimeは幅広いハードウェアに対応している汎用性の高さが魅力です。Intel CPUに最適化されたOpenVINOなどもあり、ターゲットとするハードウェアやフレームワークによって使い分けることが重要です。

| 推論エンジン | 主な特徴 | 得意なハードウェア |

|---|---|---|

| TensorRT | NVIDIA GPUでの性能を最大化する機能が豊富 | NVIDIA GPU |

| ONNX Runtime | クロスプラットフォーム対応で汎用性が高い | CPU, GPU (NVIDIA, AMD), etc. |

| OpenVINO | Intel製ハードウェアでの推論に特化 | Intel CPU, iGPU, VPU |

TensorRTを利用する際のコストは?

TensorRT自体は、NVIDIA CUDA Toolkitの一部として無償で提供されています。 そのため、ソフトウェアライセンスに関する追加のコストは発生しません。ただし、TensorRTはNVIDIA製のGPU上で動作することが前提となっているため、そのハードウェアを所有または利用するためのコストが必要です。個人開発であればGeForceシリーズ、本格的な商用サービスであればデータセンター向けのGPUなど、用途に応じたNVIDIA GPUへの投資が、実質的なコストと言えるでしょう。

まとめ:TensorRTの基本から応用までのポイント整理

この記事では、AIモデルの推論を高速化するNVIDIA TensorRTについて、その基礎から応用までを網羅的に解説しました。TensorRTは、レイヤー融合や精度調整といった技術を駆使し、NVIDIA GPUの性能を最大限に引き出す最適化ツールです。Dockerを使えば比較的簡単に導入でき、画像分類や自然言語処理など、幅広い分野でその効果を発揮します。あなたのAIモデルは、まだ本来のスピードを出せていないかもしれません。本記事で紹介した知識や事例を参考に、ぜひTensorRTの導入を検討し、開発するAIアプリケーションのパフォーマンスを劇的に向上させてください。あなたの挑戦が、新たな価値を生み出す一歩となるでしょう。