えんぴっちょ

えんぴっちょ近年AI技術、特にディープラーニングは目覚ましい発展を遂げており、その中でも「ResNet(レズネット)」は画像認識の分野に革命をもたらした非常に重要な技術です。皆さんも「AIで画像認識の精度が上がった」というニュースを耳にしたことがあるかもしれませんが、その背景にはResNetの存在が大きく関わっています。しかし、その名前は聞いたことがあっても、どのような仕組みで、何がすごいのか、専門的で難しいと感じている方も多いのではないでしょうか。この記事では、AIを学び始めた大学生や、これから実務で活用したいと考えているエンジニアの方々に向けて、ResNetの基本的な概念から、その強力なメリット、そして導入する上で知っておきたいデメリットまで、専門用語を極力使わずに分かりやすく解説していきます。この記事を読み終える頃には、ResNetがなぜこれほどまでに評価されているのか、その核心を理解し、あなたの知識やスキルとして活用できるようになるでしょう。

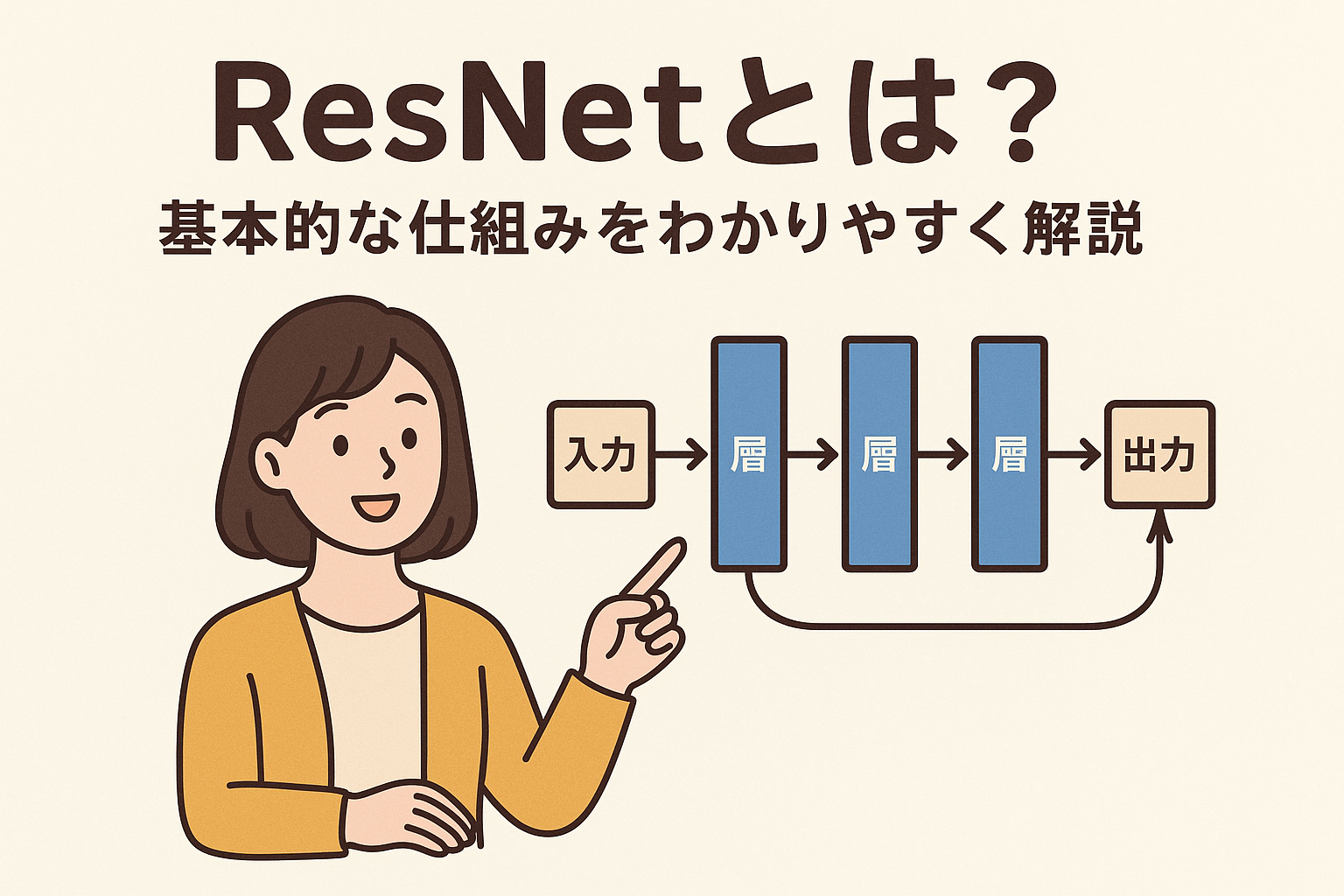

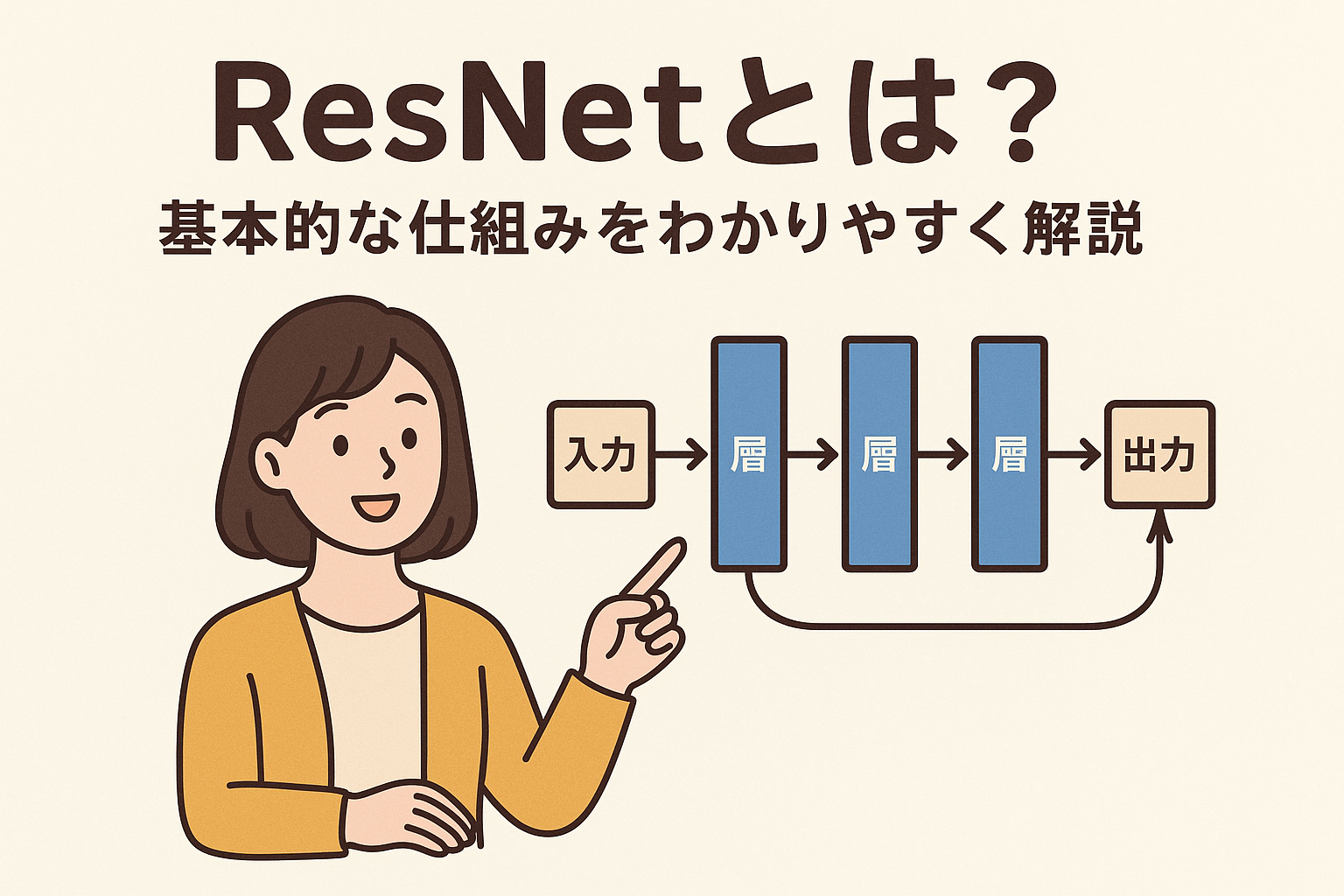

ResNetとは?基本的な仕組みをわかりやすく解説

ResNet(Residual Network)とは、2015年にマイクロソフトの研究チームによって発表された、畳み込みニューラルネットワーク(CNN)の一種です。 このモデルが登場するまで、AIの画像認識は「ネットワークの層を深くすればするほど賢くなる」と考えられていましたが、実際にはある一定の深さを超えると逆に性能が落ちてしまうという大きな課題を抱えていました。ResNetは、この課題を画期的な方法で解決し、それまで不可能とされていた100層を超えるような非常に深いネットワークの学習を可能にしたのです。 この功績により、画像認識コンペティション「ILSVRC 2015」で優勝を果たし、その後の深層学習モデルの発展に絶大な影響を与えました。 今日の多くの画像認識技術は、ResNetのアイデアを基礎としており、まさに現代AIの土台を築いた技術と言えるでしょう。

勾配消失問題の解決と学習時間の短縮を可能にした理由

従来の深層学習モデルが抱えていた大きな問題が「勾配消失問題」です。 これは、ネットワークの層を深くしていくと、学習の際に必要な情報(勾配)が入力層に近づくにつれてどんどん小さくなり、最終的にはほとんどなくなってしまう現象を指します。 勾配が消えてしまうと、AIはどこを修正すれば良いのか分からなくなり、学習が全く進まなくなってしまいます。 その結果、層を増やしても性能が上がらない、あるいはかえって悪化するというジレンマに陥っていました。

ResNetは、後述する「スキップ接続」という仕組みを用いることで、この勾配消失問題を巧みに回避しました。 情報が層を飛び越えて直接伝わる道筋を作ったことで、どれだけネットワークが深くなっても勾配がしっかりと伝わり、効率的な学習と時間短縮が可能になったのです。

ResNetが導入した残差ブロックとスキップ接続の特徴

ResNetの最大の特徴であり、革新性の核となるのが「残差ブロック(Residual Block)」と「スキップ接続(Skip Connection)」という構造です。これまでのネットワークでは、入力データは層を順番に一つずつ通過して処理されていました。しかしResNetでは、いくつかの層をまとめた「残差ブロック」ごとに入力データ(x)を、層を通過した後の出力(F(x))に直接足し合わせる「スキップ接続」という近道(バイパス)を設けています。

この構造により、ネットワークは入力と出力の差分、つまり「残差(Residual)」だけを学習すれば良くなります。もし追加した層が不要だった場合、ネットワークは残差をゼロに近づけるだけでよく、入力をそのままスルーさせることが容易になります。このシンプルなアイデアによって、層を追加しても性能が低下するリスクを大幅に減らし、ネットワークの深層化を実現したのです。

ResNetを活用する6つのメリット

ResNetは、深層学習における画期的なモデルとして、多くのメリットを提供します。その優れた特性は、研究分野だけでなく、実際のビジネスシーンにおいても幅広く活用されています。ここでは、ResNetを導入することで得られる具体的な6つの利点について、一つずつ詳しく見ていきましょう。

大規模なシステムに応用できる拡張性の高さ

ResNetの最大のメリットの一つは、その高い拡張性にあります。従来のモデルでは困難だったネットワークの深層化を可能にしたことで、非常に複雑で大規模なシステムへの応用が容易になりました。例えば、膨大な数の画像を扱う自動運転システムや、高度な精度が求められる医療画像の解析など、これまで技術的な限界で実現が難しかった分野でも、ResNetを基盤とすることで高い性能を発揮できます。層を深くしても安定して学習が進むため、問題の複雑さに応じて柔軟にモデルの規模を調整できる点は、実用面で大きな強みと言えるでしょう。

高速なデータ処理が可能になる仕組み

ResNetは、高速なデータ処理を実現できる点も大きなメリットです。その理由は、残差ブロックとスキップ接続の構造にあります。この仕組みによって勾配がネットワーク全体に効率良く伝わるため、学習がスムーズに進み、収束までの時間が短縮されます。また、ResNetの一部のモデル(例えばResNet-50)は、層の数が多いにもかかわらず、VGGのような古いモデルと比較してパラメータ数が少なく、計算効率が高いという特徴も持っています。これにより、学習だけでなく、実際の推論(画像認識など)においても高速な処理が可能となり、リアルタイム性が要求されるアプリケーションでの活用が進んでいます。

他のニューラルネットワークと連携しやすい設計

ResNetは、単体で高性能なだけでなく、他のニューラルネットワークと組み合わせやすいというメリットも持っています。その構造はモジュール化されており、特に画像から特徴を抽出する部分(バックボーン)として非常に優れています。例えば、医療画像の領域分割でよく使われる「U-Net」というモデルのエンコーダー部分にResNetを用いることで、精度を向上させることができます。このように、物体検出モデルの「Faster R-CNN」や、セグメンテーションモデルの「DeepLab」など、多くの先進的なモデルがResNetをその基盤として採用しており、高い拡張性と連携能力が証明されています。

幅広い用途に対応する汎用性の高さ

ResNetが持つ汎用性の高さも、特筆すべきメリットです。ResNetは、特定のデータセットに過度に依存せず、より一般的で本質的な特徴を学習する能力に長けています。そのため、未知のデータに対しても高い精度を維持することができ、画像分類という基本的なタスクはもちろんのこと、以下のような幅広い用途でその力を発揮します。

- 物体検出:画像の中にある物体の位置と種類を特定する

- 画像セグメンテーション:画像をピクセル単位で領域分けする

- 顔認識:画像から特定の人物を識別する

このように、一つのモデル構造が多様なコンピュータビジョン分野で応用できるため、多くの開発者にとって非常に価値のある選択肢となっています。

転移学習による効率的なモデル活用法

ResNetは「転移学習」との相性が非常に良いことでも知られています。転移学習とは、ある大きなデータセット(例えばImageNet)で事前に学習させたモデルの重みを、別の新しいタスクに再利用する手法です。これにより、手元にあるデータが少量であっても、効率的に高い精度のモデルを構築することが可能になります。

ResNetは、ImageNetで学習済みのモデルが広く公開されているため、誰でも簡単に転移学習を試すことができます。 ゼロからモデルを学習させる必要がないため、膨大な計算リソースと時間を節約できるこのメリットは、特にリソースが限られる個人や中小企業にとって非常に大きな魅力です。

実装の容易さと使いやすい設計思想

どんなに優れた理論でも、実装が難しければ広く普及しません。その点でResNetは、実装が非常に容易であるという大きなメリットを持っています。ResNetの構造は、同じ形の「残差ブロック」を繰り返し積み重ねるという、シンプルで再利用性の高い設計になっています。さらに、PyTorchやTensorFlowといった主要な深層学習フレームワークでは、ResNet-18, ResNet-34, ResNet-50といった様々なバリエーションが、わずか数行のコードで呼び出せるように準備されています。 この使いやすさが、研究者や開発者が複雑なモデル構造に悩むことなく、本質的な課題解決に集中できる環境を提供し、ResNetの急速な普及を後押ししたのです。

ResNet導入時に知っておきたい3つのデメリット

ResNetは非常に強力で多くのメリットを持つ一方で、導入する際には考慮すべきデメリットもいくつか存在します。これらの課題を事前に理解しておくことで、より効果的にResNetを活用し、潜在的な問題を未然に防ぐことができます。ここでは、主な3つのデメリットと、その対応策について解説します。

計算リソースが多く必要になることへの対応

ResNet、特にResNet-50やResNet-152といった深いモデルは、その複雑さから多くの計算リソースを必要とします。具体的には、高性能なGPU(Graphics Processing Unit)が推奨され、それに伴いメモリ使用量も大きくなる傾向があります。個人のPCや小規模な環境では、リソース不足により学習に非常に長い時間がかかったり、そもそも実行が困難だったりする場合があります。この問題に対応するためには、Google Colaboratoryのような無料のGPU環境を活用したり、AWSやGCPなどのクラウドコンピューティングサービスを利用して、必要な時だけ高性能なリソースを借りるという方法が有効です。

過学習を防ぐために注意すべきポイント

ResNetは非常に高い表現力を持つため、学習データに対して過剰に適合してしまう「過学習」のリスクがあります。過学習に陥ると、学習データでは高い精度を出せるものの、未知の新しいデータに対しては全く性能が出ないという状態になります。特に、データセットの規模が小さい場合にこの問題は顕著になります。過学習を防ぐためには、いくつかの対策が有効です。例えば、学習データを水増しする「データ拡張(Data Augmentation)」を行ったり、モデルの複雑さを抑制する「正則化」や「ドロップアウト」といった技術を併用したりすることが挙げられます。適切な対策を講じることで、ResNetの汎化性能を高く保つことが重要です。

複雑なモデル構造を理解する際の注意点

ResNetは非常に深い層を持つため、その内部で何が起きているのかを直感的に理解するのは難しい場合があります。なぜそのように判断したのか、という根拠を説明することが困難な「ブラックボックス」問題は、ResNetにも当てはまります。 これは、特に医療診断のように、判断の根拠や説明責任が重要視される分野では大きな課題となる可能性があります。スキップ接続がどのように学習に貢献しているかを完全に解明することは、専門家にとっても容易ではありません。モデルの予測結果を解釈するための「XAI(説明可能なAI)」といった技術も研究されていますが、ResNetの複雑な構造を扱う際には、その判断の透明性には限界があることを認識しておく必要があります。

ResNetが活躍する代表的な3つの分野

ResNetの革新的なアーキテクチャは、理論上のブレークスルーに留まらず、すでに私たちの身の回りの様々な技術に応用されています。特に、その高い画像認識能力は、コンピュータビジョンをはじめとする多くの分野で目覚ましい成果を上げています。ここでは、ResNetが実際にどのような場面で活躍しているのか、代表的な3つの分野を挙げて具体的に解説します。これらの実例を知ることで、ResNetが持つポテンシャルの大きさをより深く理解できるでしょう。

コンピュータビジョンにおける画像解析の精度向上

ResNetが最も大きな影響を与えた分野は、間違いなくコンピュータビジョンです。画像に何が写っているかを識別する「画像分類」、物体の位置を特定する「物体検出」、画像の各ピクセルを意味のある領域に分割する「セグメンテーション」など、主要なタスクの精度を劇的に向上させました。従来のモデルでは難しかった非常に深い層を持つネットワークを構築できるため、より複雑で抽象的な特徴を画像から学習できます。この能力により、似たような物体の微妙な違いを見分けたり、様々な角度や照明条件の画像を正確に認識したりすることが可能になりました。自動運転車の標識認識や、スマートフォンのカメラでの顔認識など、私たちの生活に密着した技術の多くが、ResNetの恩恵を受けているのです。

医療画像解析での精緻な診断支援への活用

医療分野は、ResNetの技術が人々の健康に直接貢献している重要な領域です。レントゲンやCT、MRIといった医療画像から、がん細胞や病変といった異常箇所を検出するシステムに応用されています。人間の目では見逃してしまうような微細な兆候をAIが捉えることで、医師の診断をサポートし、早期発見・早期治療につなげることが期待されています。ResNetの深いネットワーク構造は、複雑な医療画像の中に潜む微妙なパターンの違いを学習するのに非常に適しています。これにより、診断の精度向上だけでなく、医師の負担軽減にも貢献しており、今後の医療AIの発展に欠かせない基盤技術となっています。

生物学的データの解析精度を高めるResNetの強み

ResNetの応用範囲は、画像データだけに限りません。その強力な特徴抽出能力は、生物学の分野でも活用され始めています。例えば、遺伝子配列データやタンパク質の立体構造データといった、規則性を持つ複雑なデータを解析する際に、ResNetのアーキテクチャが応用されています。これらのデータは画像とは見た目が異なりますが、データの中に潜む階層的なパターンを捉えるという点で共通しています。ResNetのモデルを応用することで、病気に関わる遺伝子の特定や、新薬開発のターゲットとなるタンパク質の機能予測など、生命科学における難解な問題の解決に貢献しています。このように、ResNetの基本思想は、画像以外の様々なデータ解析にも応用できる高い汎用性を持っています。

ResNetに関するよくある質問とその回答

ResNetについて学ぶ中で、いくつかの疑問点が出てくるかもしれません。特に、従来のモデルとの違いや、その核となる技術の仕組みについては、多くの方が関心を持つポイントです。ここでは、ResNetに関してよく寄せられる質問をピックアップし、初心者の方にも分かりやすく回答していきます。これらのQ&Aを通じて、ResNetへの理解をさらに深めていきましょう。

ResNetと従来のCNNモデルの具体的な違いは?

ResNetと従来のCNN(畳み込みニューラルネットワーク)の最も大きな違いは、「スキップ接続」の有無にあります。従来のCNNでは、層を深くすればするほど性能が落ちる「劣化問題」が発生し、深くすることが困難でした。ResNetはこの問題をスキップ接続によって解決し、100層を超えるような超深層ネットワークの学習を初めて可能にしました。主な違いを以下の表にまとめます。

| 比較項目 | 従来のCNN(VGGなど) | ResNet |

| ネットワークの深さ | 数十層が限界 | 100層以上の深層化が可能 |

| キーとなる技術 | 畳み込み層の積み重ね | 残差ブロック(スキップ接続) |

| 学習の課題 | 勾配消失・劣化問題が発生 | 勾配消失・劣化問題を抑制 |

| 学習対象 | 入力から出力を直接学習 | 入力との差分(残差)を学習 |

| 代表的なモデル | AlexNet, VGG16, VGG19 | ResNet-34, ResNet-50, ResNet-152 |

Residual ConnectionとSkip Connectionはどのように違うのか?

「スキップ接続(Skip Connection)」と「残差接続(Residual Connection)」は、非常によく似た概念で、特にResNetの文脈では同じものを指して使われることが多いです。厳密には、スキップ接続はより広い概念で、ネットワークのある層の出力を、1つ以上先の層の入力に直接加える構造全般を指します。一方、残差接続はスキップ接続の一種であり、特に入力(x)と、いくつかの層を通過した出力(F(x))を足し合わせる(F(x) + x)ことで、「残差(Residual)」を学習させることを目的とした接続方法を指します。つまり、ResNetで使われているスキップ接続は、残差学習を実現するための「残差接続」であると言えます。結論として、ResNetにおいては両者をほぼ同義として捉えて問題ありません。

ResNetが持つ勾配消失問題の解決メカニズムとは?

ResNetが勾配消失問題を解決できる理由は、その核心技術である「スキップ接続」にあります。従来の深いネットワークでは、誤差を修正するための情報(勾配)が、出力層から入力層へ逆方向に伝わる過程で、各層を通過するたびに少しずつ小さくなり、最終的にほぼゼロになってしまう「勾配消失」が起きていました。 しかし、ResNetではスキップ接続という「近道」が用意されています。この近道を通じて、勾配は途中の層での減衰をバイパスし、直接前の層へと伝わることができます。これにより、どれだけネットワークが深くなっても、入力層に近い層まで勾配がしっかりと届くようになります。この仕組みが、あたかも高速道路のバイパスのように情報の流れをスムーズにし、深いネットワーク全体の効率的な学習を可能にしているのです。

まとめ:ResNetを効果的に活用するために

この記事では、AIの画像認識技術に革命をもたらしたResNetについて、その基本的な仕組みからメリット・デメリット、そして具体的な活用事例までを分かりやすく解説してきました。ResNetの最大の特徴は「スキップ接続」を持つ「残差ブロック」にあり、この革新的なアイデアによって、従来は困難だったネットワークの深層化を可能にしました。層を深くしても学習が安定して進むため、非常に高い精度を実現できるのが大きな強みです。

その結果、画像分類や物体検出といったコンピュータビジョンの分野だけでなく、医療画像の診断支援や生物学的データの解析など、幅広い領域で応用が進んでいます。転移学習との相性も良く、少ないデータでも効率的に高性能なモデルを構築できるため、多くの開発者にとって強力なツールとなっています。 一方で、その複雑さから計算リソースが多く必要になる点や、過学習に注意が必要な点も理解しておく必要があります。ResNetは、AIエンジニアやデータサイエンティストを目指す皆さんにとって、必ず押さえておくべき重要な技術です。ぜひ、PyTorchやTensorFlowなどのフレームワークを使って、実際にResNetに触れてみてください。その驚異的な性能を体感することで、あなたのプロジェクトの可能性は大きく広がるはずです。

とは?特徴・料金・使い方・導入方法を徹底解説!-300x200.webp)

コメント