えんぴっちょ

えんぴっちょ「GPUの性能を最大限に引き出して、計算処理を高速化したい」そう考えているエンジニアやプログラマーの方は多いのではないでしょうか。しかし、具体的にどうすれば良いのか分からず、高性能なGPUを有効活用できていないケースも少なくありません。

そんな悩みを解決する鍵が、NVIDIAが提供する「CUDA」です。この記事では、CUDAという言葉は聞いたことがあるけれど詳しくは知らない、という方に向けて、その基本的な仕組みから実践的な使い方、環境構築の方法までを分かりやすく解説します。

この記事を読めば、あなたもCUDAを使いこなし、GPUのパワーを最大限に引き出すための一歩を踏み出せるでしょう。

【この記事でわかること】

- CUDAとは何か?基本的な特徴と仕組み

- CUDAプログラミングの基本的な概念と用語

- CUDA環境構築とToolkitのインストール方法

- CUDAでよく遭遇するエラーとその対処法

- CUDAのメモリモデルと高速化のポイント

- CUDAを用いた実践的なサンプルコード

- CUDAの主な活用事例

- CUDAについてよくある質問

- CUDAのまとめと今後の展望

CUDAとは何か?基本的な特徴と仕組みを解説

CUDAについて、その基本的な特徴と、なぜ高速な処理が可能なのか、その仕組みを分かりやすく解説します。

CUDAの基礎的な特徴

CUDA(Compute Unified Device Architecture)とは、NVIDIA社が開発・提供している並列コンピューティングプラットフォームであり、プログラミングモデルです。 これにより、通常はグラフィックス処理に使われるGPU(Graphics Processing Unit)の能力を、汎用的な計算処理に応用できます。

具体的には、C言語やC++、Pythonといった使い慣れたプログラミング言語の拡張機能を利用して、GPUが持つ膨大な数のコアで並列計算を行うプログラムを直接記述できるようになります。 この技術はGPGPU(General-Purpose computing on GPUs)と呼ばれ、科学技術計算やAI開発など、膨大な計算を必要とする分野で計算時間を劇的に短縮させることを可能にしました。

NVIDIA専用のGPUプログラミング拡張

CUDAはNVIDIAが自社製のGPUの性能を最大限に引き出すために開発した、専用のプラットフォームです。そのため、CUDAを用いて作成されたプログラムは、AMD社のRadeonシリーズなど、他社製のGPUでは原則として動作しません。この専属性は、NVIDIAのGPUアーキテクチャに深く最適化されていることを意味し、ハードウェアの能力を余すことなく活用できるという強力なメリットを生み出します。

開発者は、CUDAという統一された環境を通じて、NVIDIAのGPUが持つ並列処理能力を直接的に、かつ効率的に利用できるのです。このNVIDIAによるハードウェアとソフトウェアの密な連携が、CUDAを業界標準の地位に押し上げた大きな要因と言えるでしょう。

GPUの並列処理に優れる理由

GPUがなぜ並列処理に優れているのか、その理由はCPUとのアーキテクチャの違いにあります。CPUは、数個から数十個の高性能なコアを持ち、一つ一つの処理を順番に、そして複雑な命令を高速に実行することを得意としています。

一方でGPUは、CPUコアほど高性能ではないものの、「CUDAコア」と呼ばれる小規模な計算ユニットを数千個も搭載しています。この大量のコアを同時に動かすことで、単純な計算を膨大なデータに対して一斉に実行する「並列処理」において圧倒的な性能を発揮するのです。ちょうど、少数の万能な職人が複雑な仕事を一つずつこなすのがCPUだとすれば、多数の作業員が単純作業を一斉に行うのがGPU、というイメージです。

CUDAが特に活躍する分野

CUDAの圧倒的な並列計算能力は、様々な分野で活用されています。特に、膨大な計算を必要とする以下の分野では、今や欠かせない技術となっています。

- 機械学習・ディープラーニング: 大規模なニューラルネットワークの学習や推論処理を高速化します。

- 科学技術計算・シミュレーション: 物理現象のシミュレーションや、創薬、気象予測など、複雑な計算を短時間で実行できます。

- 画像・動画処理: 高解像度の映像編集やリアルタイムでのエフェクト処理、CGレンダリングを高速化します。

- データ分析: ビッグデータの解析や金融モデリングなど、大量のデータセットからの知見抽出を効率化します。

これらの分野では、CUDAを利用することで、従来は数日かかっていた計算が数時間に短縮されるなど、研究開発のスピードを飛躍的に向上させています。

CUDAプログラミングの基本的な概念と用語

CUDAプログラミングを始めるにあたり、押さえておくべき基本的な概念と、頻繁に使われる用語について解説します。

Kernel関数の基本的な仕組み

CUDAプログラミングにおいて中心的な役割を果たすのが「カーネル関数(Kernel function)」です。これは、GPU上で並列に実行される特別な関数のことを指します。C++言語で記述する場合、`__global__` という修飾子を付けて関数を定義することで、その関数がカーネルであることを示します。

プログラムの主な流れを制御するCPU(ホスト)から、このカーネル関数を呼び出すと、指定された数のスレッドがGPU(デバイス)上で同時に起動され、それぞれのスレッドが同じカーネル関数コードを実行します。この仕組みにより、大規模なデータの並列処理を効率的に実現できるのです。

Grid・Block・Threadの階層構造の解説

CUDAでは、膨大な数のスレッドを効率的に管理するために、「Grid」「Block」「Thread」という3つの階層構造が用いられます。

- Thread (スレッド): 並列処理における最小の実行単位です。各スレッドは、一つの計算処理を担当します。

- Block (ブロック): 複数のスレッドをまとめたグループです。同じブロック内のスレッドは、高速な共有メモリを使って互いにデータを共有したり、同期を取ったりできます。

- Grid (グリッド): 複数のブロックをまとめたものです。カーネル関数を呼び出す際に、このグリッド単位で処理を起動します。

この「スレッド → ブロック → グリッド」という階層構造により、数百万、数千万といった膨大な数のスレッドを構造的に管理し、複雑な並列処理を体系的に記述することが可能になります。

スレッドインデックス計算方法の基本

数千、数万のスレッドが同時に同じカーネル関数を実行する中で、各スレッドは自身がどのデータを処理すべきかを識別する必要があります。そのために使われるのが、`threadIdx`、`blockIdx`、`blockDim`といったCUDAに組み込まれている変数です。

- threadIdx: ブロック内におけるスレッドのID(インデックス)を取得します。

- blockIdx: グリッド内におけるブロックのID(インデックス)を取得します。

- blockDim: 1つのブロックに含まれるスレッドの数を取得します。

これらの変数を組み合わせることで、各スレッドはグリッド全体で一意なグローバルIDを計算できます。例えば、1次元のデータ処理の場合、「blockIdx.x * blockDim.x + threadIdx.x」という計算式で、自分が処理すべきデータの配列インデックスを特定できます。これにより、各スレッドが適切に作業を分担し、データ全体を網羅的に処理することが可能になるのです。

CUDA環境構築とToolkitのインストール方法

実際にCUDAプログラミングを始めるための環境構築、特にCUDA Toolkitのインストール手順について解説します。

CUDA Toolkitの主なコンポーネント

CUDA Toolkitは、CUDA開発に必要なツール一式が含まれたパッケージです。 主なコンポーネントには以下のようなものがあります。

| コンポーネント | 説明 |

| NVCC (NVIDIA C/C++ Compiler) | CUDA C/C++で書かれたソースコードをコンパイルするためのコンパイラです。 |

| CUDAライブラリ | cuBLAS(行列演算)、cuFFT(高速フーリエ変換)、cuDNN(ディープラーニング用)など、特定の計算を高速化するための最適化されたライブラリ群が含まれています。 |

| 開発ツール | Nsight Systems(パフォーマンス分析ツール)やNsight Compute(カーネルプロファイラ)、cuda-gdb(デバッガ)など、デバッグやパフォーマンスチューニングに役立つツールが含まれています。 |

| CUDAドライバ | アプリケーションとGPUハードウェアとの間で通信を行うためのドライバです。 |

これらのツールキットを利用することで、開発者は効率的にCUDAアプリケーションの開発、デバッグ、最適化を行うことができます。

WindowsにおけるCUDAのインストール手順

Windows環境でCUDA Toolkitをインストールする手順は以下の通りです。

- 事前準備:

- NVIDIA製のCUDA対応GPUが搭載されていることを確認します。

- 最新のNVIDIAグラフィックスドライバをインストールします。

- CUDAはC++コンパイラを必要とするため、Microsoft Visual Studio(C++によるデスクトップ開発ワークロードを含む)を事前にインストールしておきます。

- CUDA Toolkitのダウンロード:

- NVIDIAの公式サイトのダウンロードページにアクセスします。

- OS、アーキテクチャ、バージョンを選択し、インストーラをダウンロードします。

- インストール:

- ダウンロードしたインストーラを実行します。

- 基本的には「高速(推奨)」設定を選択し、画面の指示に従って進めるだけでインストールが完了します。

- 動作確認:

- コマンドプロンプトを開き、「nvcc -V」と入力します。

- CUDAのバージョン情報が表示されれば、正しくインストールされています。

LinuxにおけるCUDAのインストール手順

UbuntuやRocky LinuxなどのLinuxディストリビューションにCUDA Toolkitをインストールする手順の概要は以下の通りです。

- 事前準備:

- NVIDIA製のCUDA対応GPUが搭載されていることを確認し、「nvidia-smi」コマンドで認識されているかチェックします。

- GCCコンパイラなど、ビルドに必要なツールチェーンがインストールされていることを確認します。

- CUDA Toolkitのダウンロード:

- NVIDIAの公式サイトのダウンロードページにアクセスします。

- 使用しているLinuxディストリビューション、アーキテクチャ、バージョンを選択し、インストール方法(runfileまたはパッケージマネージャ)を選びます。

- インストール:

- 画面に表示されるコマンドを順番に実行します。パッケージマネージャを使用する方法が、依存関係も自動で解決されるため推奨されます。

- 環境変数の設定:

- インストール後、「~/.bashrc」などの設定ファイルに、CUDAライブラリへのパスを追加します。

- 例: `export PATH=/usr/local/cuda/bin${PATH:+:${PATH}}`

- 動作確認:

- ターミナルを再起動し、「nvcc -V」と入力してバージョン情報が表示されることを確認します。

インストール時の注意点と互換性チェック

CUDA Toolkitをインストールする際には、いくつかの注意点があります。最も重要なのは、NVIDIAドライバのバージョンとCUDA Toolkitのバージョンの互換性です。使用したいCUDA Toolkitが要求するドライバのバージョンを満たしているか、事前にリリースノートで確認する必要があります。

もし満たしていない場合は、先にドライバをアップデートしてください。また、既存の古いバージョンのCUDAがインストールされている場合は、一度アンインストールしてから新しいバージョンをインストールすることが推奨されます。互換性のない組み合わせでインストールすると、コンパイルエラーや実行時エラーの原因となるため、慎重に確認作業を行いましょう。

CUDAでよく遭遇するエラーとその対処法

CUDAプログラミングでは、特有のエラーに遭遇することがあります。ここでは、代表的なエラーとその対処法、そして開発を助けるツールについて紹介します。

CUDAのビルドエラーを解決する方法

CUDAプログラムのコンパイル時に発生するビルドエラーは、初心者にとって最初の関門です。よくあるエラーとしては、「`undefined reference to …`」といったリンクエラーや、ホストコード(CPU側)とデバイスコード(GPU側)の記述ミスに起因するものがあります。

これらのエラーに対処するには、まずエラーメッセージをよく読むことが重要です。`nvcc`コンパイラの出すエラーメッセージには、問題の原因を特定するヒントが含まれています。また、CUDAのAPI関数は多くがエラーコードを返すため、各関数呼び出しの戻り値を確認し、エラーが発生していないかチェックする習慣をつけることがデバッグの効率を上げます。

プロファイリングツールのNsight Systemsの活用法

プログラムが期待通りに動作しない、あるいは思ったほど速度が出ない、といった問題に直面したとき、非常に強力な味方となるのがプロファイリングツールです。NVIDIA Nsight Systemsは、アプリケーション全体の動作をシステムワイドに可視化するツールです。

CPUとGPUで実行された処理、メモリ転送、カーネルの実行などがタイムライン上に表示されるため、プログラムのどこがボトルネックになっているかを直感的に把握できます。 例えば、GPUが計算している間にCPUが遊んでいないか、CPUとGPU間のデータ転送に時間がかかりすぎていないかなどを分析し、パフォーマンス改善の糸口を見つけることができます。

カーネルプロファイラNsight Computeの使い方

Nsight Systemsでアプリケーション全体のボトルネックを特定したら、次はその原因となっている個別のカーネル関数を詳細に分析します。その際に使用するのが、インタラクティブなカーネルプロファイラであるNVIDIA Nsight Computeです。

このツールを使うと、特定のカーネル関数について、メモリへのアクセス効率、計算ユニットの使用率、キャッシュのヒット率といった非常に詳細なパフォーマンスメトリクスを取得できます。 例えば、「メモリ律速(メモリアクセスがボトルネック)」なのか「計算律速(演算能力がボトルネック)」なのかを判断し、それに応じたコードの最適化(メモリアクセスのパターン変更や計算方法の見直しなど)を行うための具体的な情報を得ることが可能です。

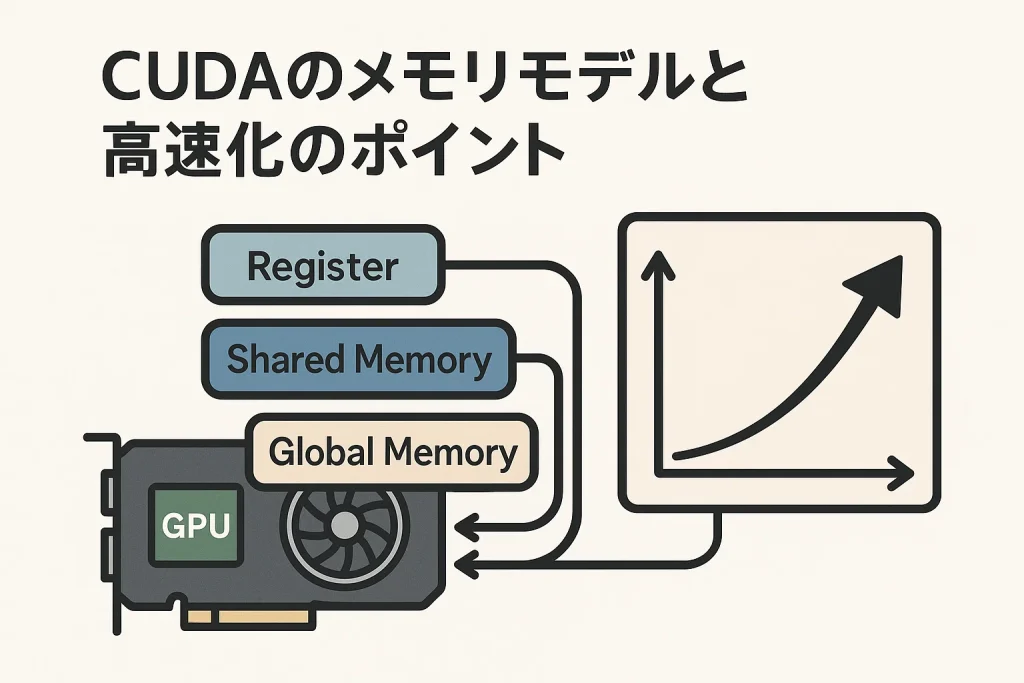

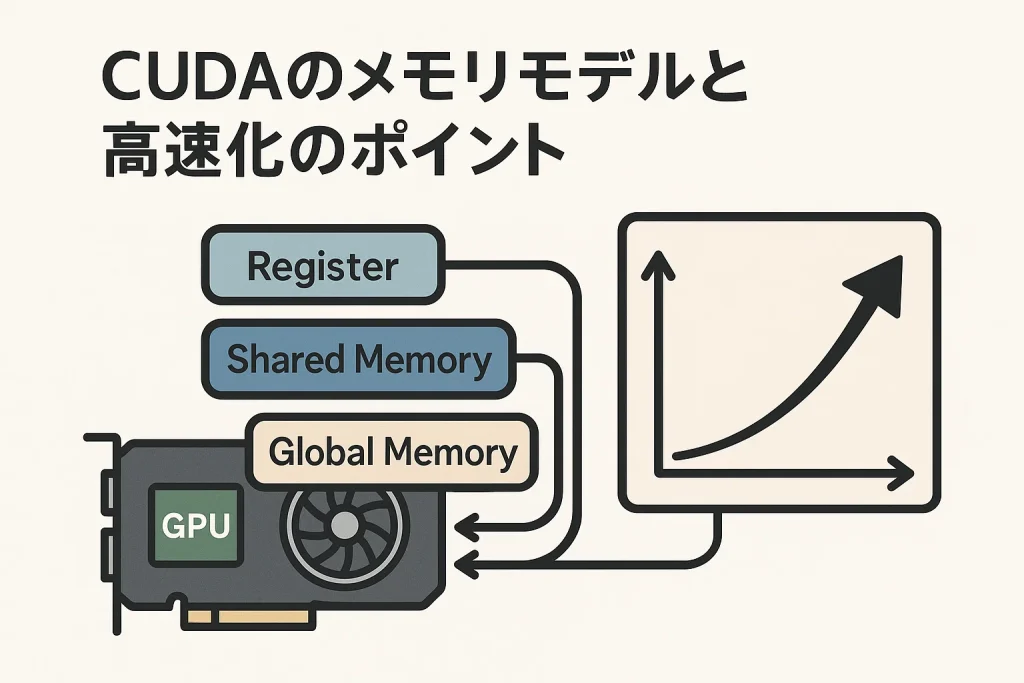

CUDAのメモリモデルと高速化のポイント

CUDAプログラミングの性能を最大限に引き出すためには、GPUが持つ独特のメモリ階層を理解し、それを意識したプログラミングが不可欠です。メモリへのアクセス方法一つで、プログラムの実行速度は劇的に変化します。ここでは、CUDAのメモリモデルの基本と、高速化を実現するための重要なポイントについて解説します。

CUDAのメモリ種類とその特徴

CUDAでは、速度やアクセス範囲が異なる複数のメモリを使い分けることができます。それぞれの特徴を理解し、データの内容やアクセスパターンに応じて最適なメモリを選択することが、高速化の第一歩です。

| メモリ種類 | 特徴 |

| レジスタ | スレッドごとに固有の超高速なメモリです。カーネル内で宣言された変数が自動的に割り当てられますが、容量は非常に小さいです。 |

| 共有メモリ | ブロック内のスレッド間で共有できる高速なオンチップメモリです。グローバルメモリから読み込んだデータを再利用する際に活用すると、メモリアクセスを大幅に削減できます。 |

| グローバルメモリ | GPUに搭載されている大容量のメモリ(VRAM)で、すべてのスレッドからアクセス可能です。CPUとGPU間のデータ転送もこのメモリを介して行われますが、アクセス速度は共有メモリに比べて大幅に遅くなります。 |

| コンスタントメモリ | すべてのスレッドから読み取り専用でアクセスできるメモリです。すべてのスレッドが同じ値にアクセスする場合にキャッシュが効き、高速に読み取れます。 |

| テクスチャメモリ | コンスタントメモリと同様に読み取り専用で、空間的な局所性を利用したキャッシュ機構を備えています。画像処理などで周辺の画素値を参照するような場合に有効です。 |

メモリアクセスの最適化(協調アクセス)

グローバルメモリアクセスの速度は、CUDAプログラム全体のパフォーマンスを左右する最も重要な要素の一つです。このアクセスを効率化する鍵となるのが「コアレッシング(Coalesced Access)」と呼ばれる仕組みです。

GPUはメモリをまとめて読み書きするため、ワープ(連続した32スレッドの集まり)内のスレッドが、メモリ上の連続した領域に同時にアクセスすると、これらのアクセスが1回のメモリアクセスにまとめられます。これにより、メモリ帯域幅を最大限に活用し、転送時間を劇的に短縮できるのです。プログラムを設計する際は、常にこのコアレッシングを意識し、スレッドIDとメモリアドレスが綺麗に対応するように心がけることが重要です。

バンク競合を防ぐための方法

共有メモリはグローバルメモリに比べて非常に高速ですが、使い方を誤ると「バンクコンフリクト(Bank Conflict)」という現象が発生し、性能が大幅に低下することがあります。共有メモリは、複数の「バンク」と呼ばれる区画に分かれています。同じワープ内の複数のスレッドが、同時に同じバンクにアクセスしようとすると競合が発生し、アクセスが直列化されてしまうのです。

これを避けるためには、スレッドがアクセスするメモリアドレスが、異なるバンクに分散するように工夫する必要があります。例えば、2次元配列を扱う際に行と列を入れ替えてアクセスしたり、意図的に未使用の領域(パディング)を加えてアドレスをずらしたりする方法が有効です。

cudaMemcpyを利用したデータ転送の最適化

GPUでの計算がいくら高速でも、その前後のCPU(ホスト)とGPU(デバイス)間のデータ転送がボトルネックになっては意味がありません。この転送には`cudaMemcpy`という関数が使われますが、この時間をいかに短縮するかが重要です。

最適化の手法としては、まず第一に不要なデータ転送をなくすことが挙げられます。また、計算とデータ転送を同時に行う「非同期転送(Asynchronous Transfer)」も有効な手段です。`cudaMemcpyAsync`関数とCUDAストリームを使うことで、カーネル実行とデータ転送をオーバーラップさせ、GPUが遊んでいる時間をなくすことができます。さらに、CPU側のメモリを「ページロックメモリ(Pinned Memory)」として確保することで、OSのページングを介さずDMA転送が可能になり、転送速度を向上させられます。

CUDAを用いた実践的なサンプルコード

CUDAの概念を理解したら、次は実際にコードを書いて動かしてみましょう。ここでは、基本的なものから少し応用的なものまで、3つのサンプルコードを紹介します。

ベクトル加算を行う簡単なサンプル

ベクトル加算は、CUDAプログラミングにおける「Hello, World!」のようなものです。2つのベクトルAとBの各要素を足し合わせて、結果をベクトルCに格納する単純な処理です。

このサンプルを通じて、ホスト(CPU)側でのデータ準備、`cudaMalloc`によるデバイス(GPU)メモリの確保、`cudaMemcpy`によるデータ転送、カーネル関数の起動、そして結果の取得という一連の基本的な流れを学ぶことができます。各スレッドは、自身のIDを用いて担当する配列のインデックスを計算し、AとBの対応する要素を一つだけ加算します。

行列積のサンプルコードの紹介

次にもう少し複雑な例として、行列の積を計算するサンプルを見てみましょう。単純な実装では、結果の行列Cの各要素を1つのスレッドが担当し、計算に必要な行と列のデータをグローバルメモリから何度も読み込むことになります。しかし、これではメモリアクセスが非効率です。

ここで共有メモリを活用した「タイリング(Tiling)」というテクニックが有効になります。これは、入力行列を小さな「タイル」と呼ばれる部分行列に分割し、そのタイルをブロックごとに共有メモリに読み込んでから計算を行う手法です。これにより、グローバルメモリアクセスの回数を劇的に減らし、計算を大幅に高速化できます。

グレースケール画像変換のサンプル

画像処理もCUDAが得意とする分野の一つです。カラー画像を白黒のグレースケール画像に変換する処理を考えてみましょう。

この処理では、画像の各ピクセル(画素)に対して、RGB(赤・緑・青)の各色成分の値から輝度(明るさ)を計算するという同じ処理を適用します。このタスクは並列処理に非常に適しており、各スレッドが1つのピクセルを担当するように割り当てることで、巨大な画像でも瞬時に変換することが可能です。このサンプルは、CUDAがグラフィックス以外の画像処理タスクにも強力なツールであることを示しています。

CUDAの主な活用事例

CUDAの強力な並列処理能力は、学術研究から産業応用まで、幅広い分野で革新をもたらしています。ここでは、その代表的な活用事例をいくつか紹介します。

ディープラーニングへの応用(Pinterestの例)

今日のAIブームを支えるディープラーニングは、CUDAの最も重要な応用分野の一つです。画像共有サービス大手のPinterestは、ユーザーの興味に合った画像を推薦するモデルの高速化にGPUとCUDAを活用しています。 CPUで処理していた際にはコストと遅延が課題でしたが、GPUに移行し、CUDAカーネルの最適化やメモリコピーの統合といったチューニングを行うことで、推論効率を100倍以上に向上させ、ユーザーエンゲージメントを最大16%も改善させることに成功しました。 このように、大規模なニューラルネットワークの学習や推論にはCUDAが不可欠となっています。

数値シミュレーションでの活用例

科学技術計算の分野でもCUDAは広く活用されています。例えば、流体力学シミュレーションでは、気体や液体の複雑な動きを計算するために膨大な計算量が必要ですが、CUDAを用いることで従来よりもはるかに高速かつ大規模なシミュレーションが可能になりました。

その他にも、新薬開発のための分子動力学計算、天気予報の精度向上、金融市場のリスク分析(モンテカルロシミュレーション)など、様々な分野で研究開発のスピードアップに貢献しています。

画像処理分野での活用

GPUが元々グラフィックス処理を得意としていたこともあり、画像処理はCUDAの能力が活きる分野です。医療分野では、CTやMRIといった医用画像の3D再構成や解析を高速化し、より迅速で正確な診断を支援しています。

また、放送・映像業界では、高解像度ビデオのリアルタイム編集やCGレンダリング、自動運転技術においては、カメラ映像から歩行者や他の車両を認識する処理などでCUDAが使われており、私たちの身近なところでその技術が活躍しています。

CUDAについてよくある質問

これからCUDAを始めるにあたって、多くの方が抱くであろう疑問にお答えします。

CUDAを利用できるGPUのモデルは?

CUDAはNVIDIA製のGPUでのみ利用可能です。具体的には、GeForceシリーズ、NVIDIA RTX(旧Quadro)シリーズ、Teslaシリーズ、JetsonシリーズなどのCUDA対応GPUが必要です。また、各GPUには「Compute Capability(計算能力)」というバージョン番号があり、これがそのGPUで利用できるハードウェア機能や命令セットを定義しています。使用したいCUDA Toolkitのバージョンが、お使いのGPUのCompute Capabilityに対応しているかを確認する必要があります。

CUDAとGPUドライバのバージョン互換性は?

これは非常に重要で、しばしば開発者を悩ませる問題です。CUDA Toolkitを動作させるには、対応する最低限のNVIDIAドライババージョンがインストールされている必要があります。新しいCUDA Toolkitは、基本的に新しいドライバを要求します。インストールするCUDA Toolkitのリリースノートで、要求されるドライバのバージョンを必ず確認してください。バージョンの不整合は、コンパイルエラーや実行時エラーの直接的な原因となるため、環境構築の際には最も注意すべき点の一つです。

CUDAで開発する際におすすめのIDEは?

CUDAプログラムの開発には、いくつかの統合開発環境(IDE)が利用できます。

- Microsoft Visual Studio: Windows環境での定番です。NVIDIAが提供する「Nsight Visual Studio Edition」という拡張機能を導入することで、CUDAコードのシンタックスハイライト、デバッグ、プロファイリングといった強力なサポートを受けることができます。

- Visual Studio Code (VS Code): クロスプラットフォームで人気の高機能エディタです。 「C/C++」拡張機能と「Nsight Visual Studio Code Edition」を組み合わせることで、Windows、Linuxを問わず快適なCUDA開発環境を構築できます。 リモート開発機能も充実しており、サーバー上のGPUを利用した開発にも適しています。

どちらを選ぶかは個人の好みや開発環境によりますが、近年ではVS Codeの柔軟性や拡張性の高さから、利用者も増えているようです。

CUDAのまとめと今後の展望

この記事では、GPUの能力を最大限に引き出すための並列コンピューティングプラットフォーム「CUDA」について、その基本的な仕組みからメモリモデル、高速化のポイント、具体的な活用事例までを解説してきました。

CUDAは、NVIDIA製GPU専用という制約はあるものの、ハードウェアに最適化された強力な開発環境を提供し、AIや科学技術計算といった分野でデファクトスタンダードとしての地位を確立しています。Grid、Block、Threadといった階層構造や、グローバルメモリ、共有メモリといったメモリの種類を理解し、メモリアクセスの最適化を意識することが、CUDAプログラミングのパフォーマンスを向上させる鍵となります。

最初は難しく感じるかもしれませんが、ベクトル加算のような簡単なサンプルから始め、徐々にNsightのようなプロファイリングツールを使いこなせるようになれば、あなたもGPUの真の力を引き出すことができるでしょう。

今後、AIやビッグデータ解析の重要性はますます高まり、CUDAの役割もさらに拡大していくことは間違いありません。この機会にぜひCUDAプログラミングの世界に足を踏み入れ、計算処理の高速化を実現してみてはいかがでしょうか。

コメント